LoRA性能全方位解析LoRA性能不输全参微调

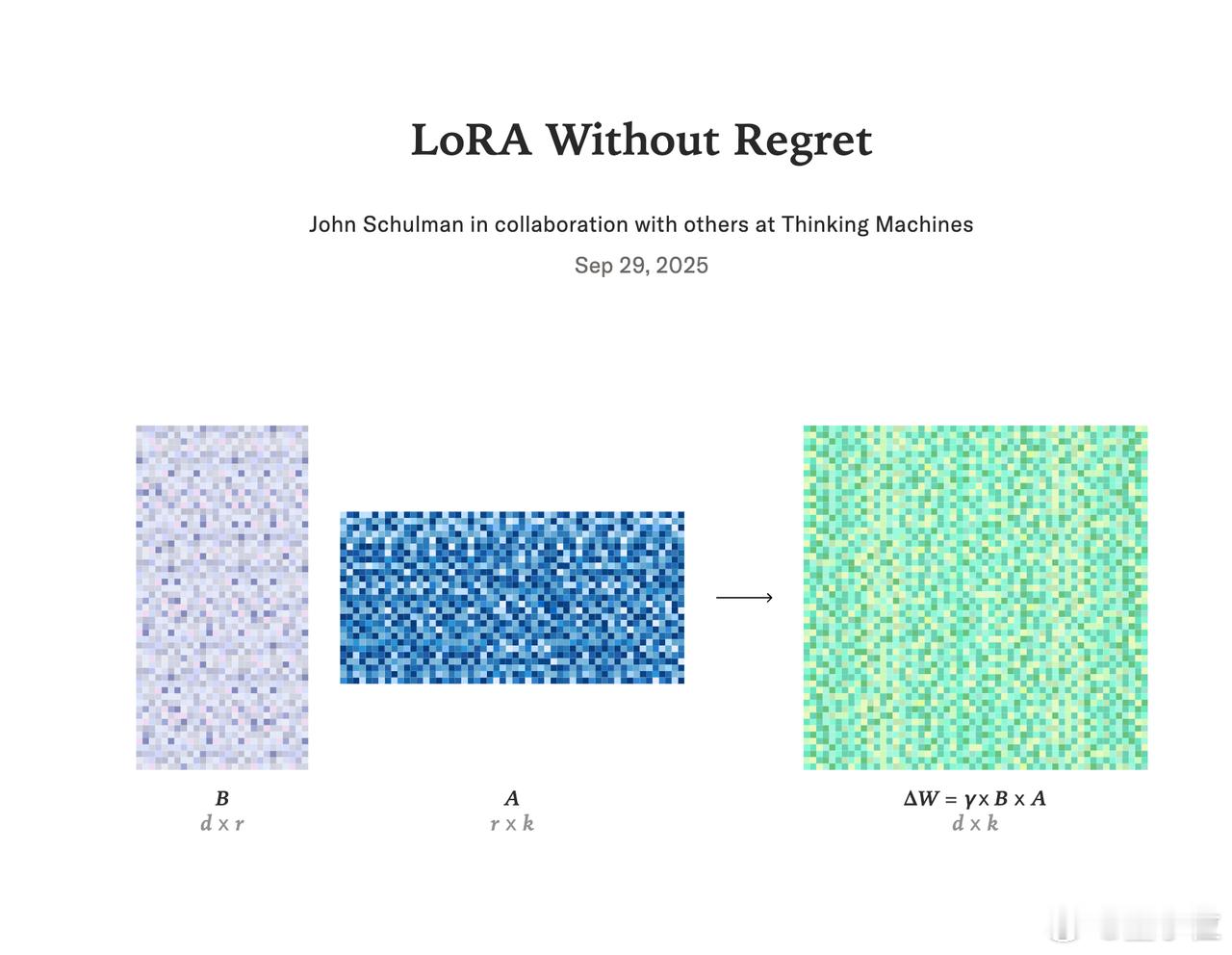

LoRA(Low-Rank Adaptation,低秩适应)是一种“轻量级微调”技术,训练时只需更新少量参数(而不是全量权重),被广泛用于降低大模型微调的成本。

但它到底能不能媲美传统的全参微调(Full Fine-Tuning)?

对此,Thinking Machines团队做了非常系统的研究,得出了一些意外结论:

- 在大多数“微调场景”中,LoRA的最终效果和FullFT几乎一样;

- 即便是用在RL(强化学习)上,LoRA只要rank设置得当,表现也完全Ok;

- 唯一的前提是:LoRA要应用在所有层上,特别是MLP和MoE层;如果只是把LoRA加在Attention上,哪怕调高rank也难以跟上性能。

实验还发现:

- 超大数据集场景下LoRA会因容量不够而性能下滑;

- LoRA对batch size更敏感,不能像FullFT那样随便加大;

- 不同rank下,LoRA最优学习率基本一致,而且比FullFT高10倍左右。

他们还对LoRA做了信息论级别的分析,推导出在RL中每个episode提供的信息量极少,因此即使是rank=1的LoRA也能承载所有训练信息,而且绰绰有余。

LoRA的另一个隐形优势,是训练资源的效率比FullFT高:全参微调每步训练要做3倍于推理的计算量,而LoRA只需略高于2倍,大约省下1/3 FLOPs。

总结下来,只要任务数据量不过大、LoRA加在所有层上,并用对学习率,LoRA就能做到性能基本无损,同时大幅节省训练资源,是个非常值得推广的方案。

原文链接:thinkingmachines.ai/blog/lora/