ThinkingMachine新研究刷屏小模型训练更具性价比了

Thinking Machine的新研究正在刷屏,前OpenAI CTO Mira Murati亲自转发,包括翁荔在内,连串大佬看完都直呼“优雅”。【图1】

这项研究提出了一个新术语:On-Policy Distillation(在线策略蒸馏),目标是让小模型以更低成本获得更强专业能力。【图2】

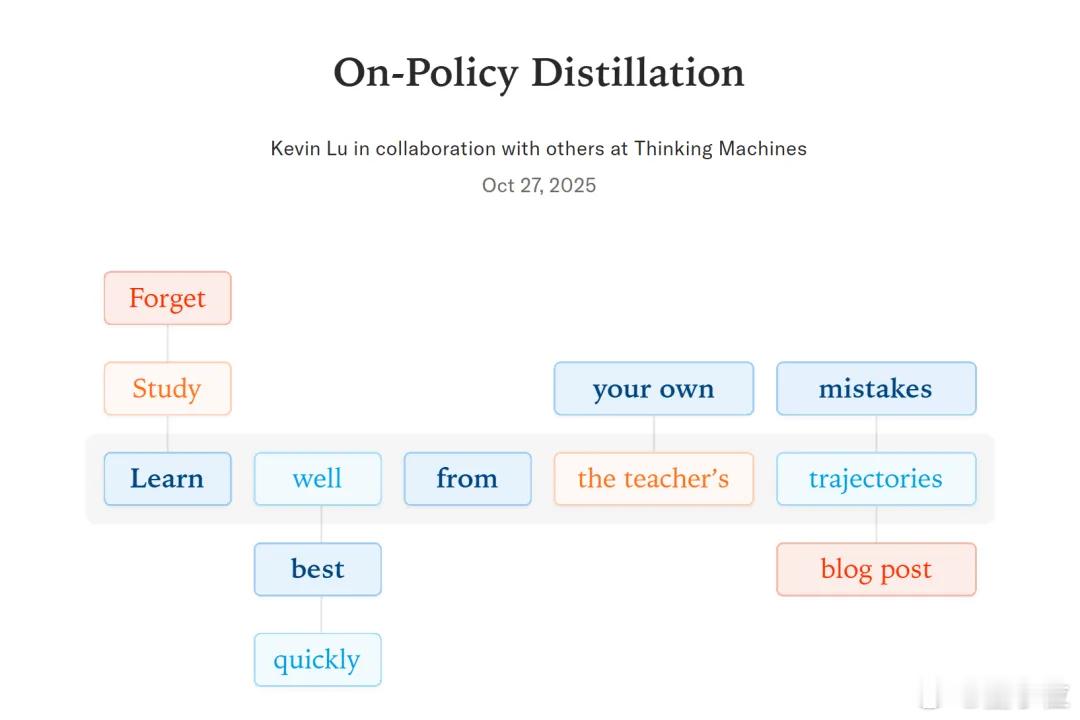

简单说,它融合了强化学习(RL)和微调(SFT)的优点:

- 像RL一样让模型自己解题、独立探索;

- 像SFT一样每一步都有“老师”监督,出错就立刻修正。

整个过程就像一个“全程陪练的金牌教练”,一边放手训练,一边随时指导。核心指标叫逆向KL散度,越像老师奖励越高,越不像惩罚越狠。

效果也非常显著:

1. 数学训练实验中,32B教师模型只用了150步就把8B学生从60分拉到70分,训练效率比传统方法高9~30倍;

2. 企业助理实验中,模型在学习新知识后遗忘旧技能的问题,也通过这个方法得以修复——恢复了通用能力,且新知识保持不变。

研究由OpenAI前研究员Kevin Lu主导,他曾负责4o-mini等小模型项目。这次的成果也被视为他继续推动“小模型高效训练”方向的重要一环。

从效果看,这项方法有潜力成为小模型训练的“新标准”:不卷参数量、不拼算力,照样能把模型训得又准又稳。

论文地址: