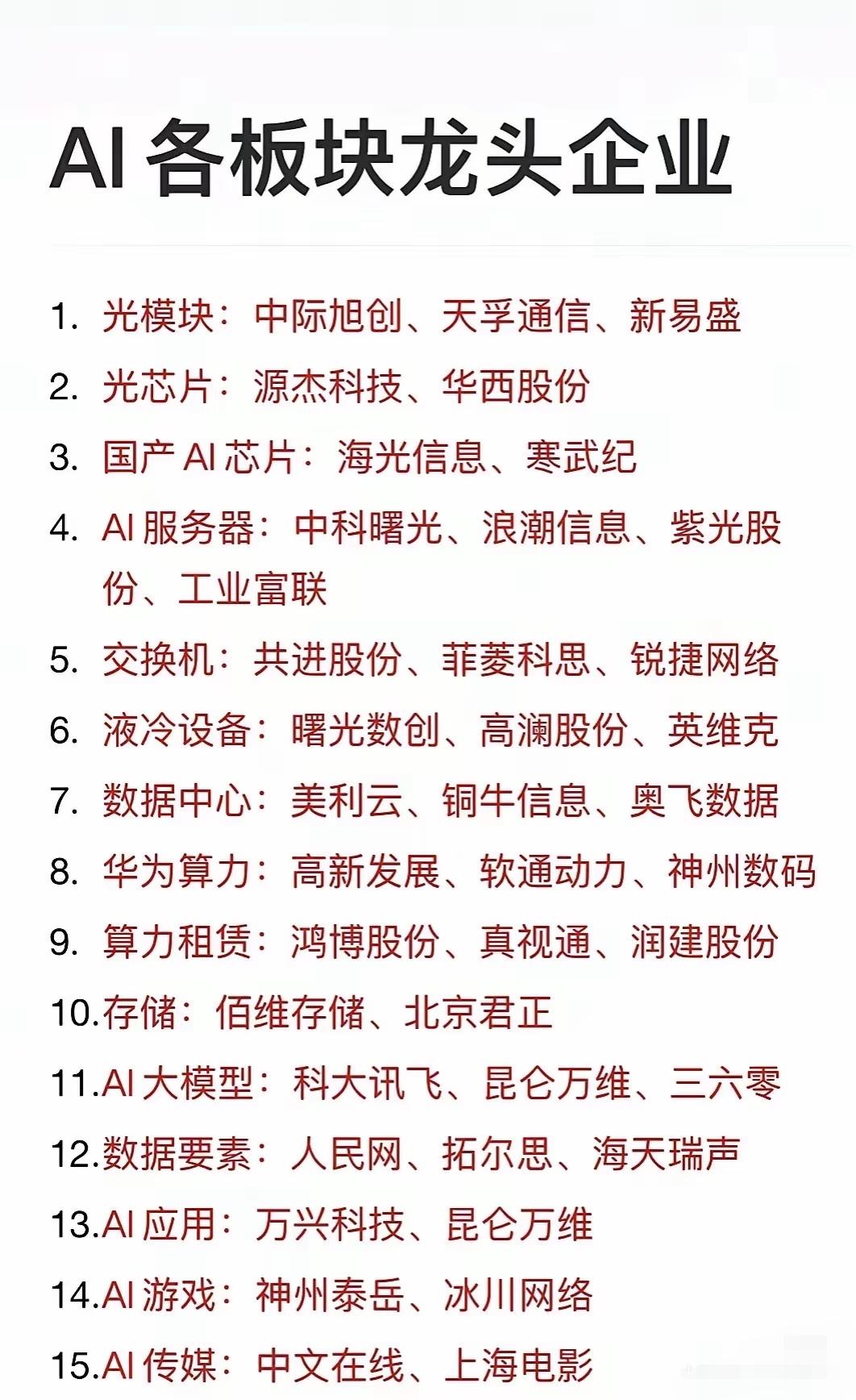

⚡【AI黑科技④】AI数据中心的“电力困局” 个人观点,仅供参考 🔥 大模型爆发,全球正在掀起 AI数据中心建设热潮。但除了 GPU、HBM 这种硬件,真正限制 AI 发展的,可能是最基础的一环:电力。 一、电力需求为何暴涨? 传统互联网数据中心,主要处理存储和网页请求,功耗相对可控。 但 AI 训练不一样: 一台 满配 GPU 服务器功耗在 5~10kW,相当于 3-5 户家庭用电。 一个大模型训练可能要上万台 GPU 同时运行,连续数周。 结果就是:一个 AI 数据中心耗电量 ≈ 一个中型城市。 据国际能源署预测,到 2027 年,AI 数据中心用电量可能超过日本全国的电力消费总和。 二、全球“电力困局”案例 美国:微软、谷歌、亚马逊都在疯狂扩建数据中心,但德州、弗吉尼亚等地的电网接入申请,已经排队到 2028 年。 中国:通过“东数西算”把 AI 数据中心布局到西部靠近水电、风电的地区,但“电够了,网络不够快”,传输带宽成新瓶颈。 日本/欧洲:能源紧张+环保政策严格,新建 AI 机房面临审批难,甚至要考虑小型核电站直供。 这就是 AI行业的隐性矛盾:芯片可以买,但电力不一定批得下来。 三、行业正在探索的解法 绿色能源直供 谷歌、亚马逊投资自建风电、光伏电站。 微软甚至签下了小型核反应堆供电的长期协议。 液冷技术 传统风冷散热效率低,液冷能让 PUE(能源使用效率)降到 1.1 以下,节省近 30% 能耗。 地理转移 把数据中心建到靠近水电/风电产能的地区,比如中国西部、北欧、东南亚水电站附近。 AI算力调度 未来可能出现“跨区域算力调度”:像电力一样,算力也能“跨省交易”,谁电便宜,谁来跑训练任务。 四、为什么电力是下一道“护城河”? 芯片=大脑,再强也需要能量供给。 电力=血液,没有血液,大脑就会休克。 哪些国家能稳定提供“低成本、清洁电力”,谁就更有可能在 AI 时代赢得竞争。 这意味着,未来 AI 的竞争,不仅仅是 GPU争霸战,更是 能源格局之争。 💡结尾互动 ❓你觉得:未来 AI 数据中心最大的瓶颈,会是 GPU芯片,还是 电力供应? 💬 欢迎在评论区聊聊,如果只能投一个赛道,你会选择“芯片股”还是“新能源股”?