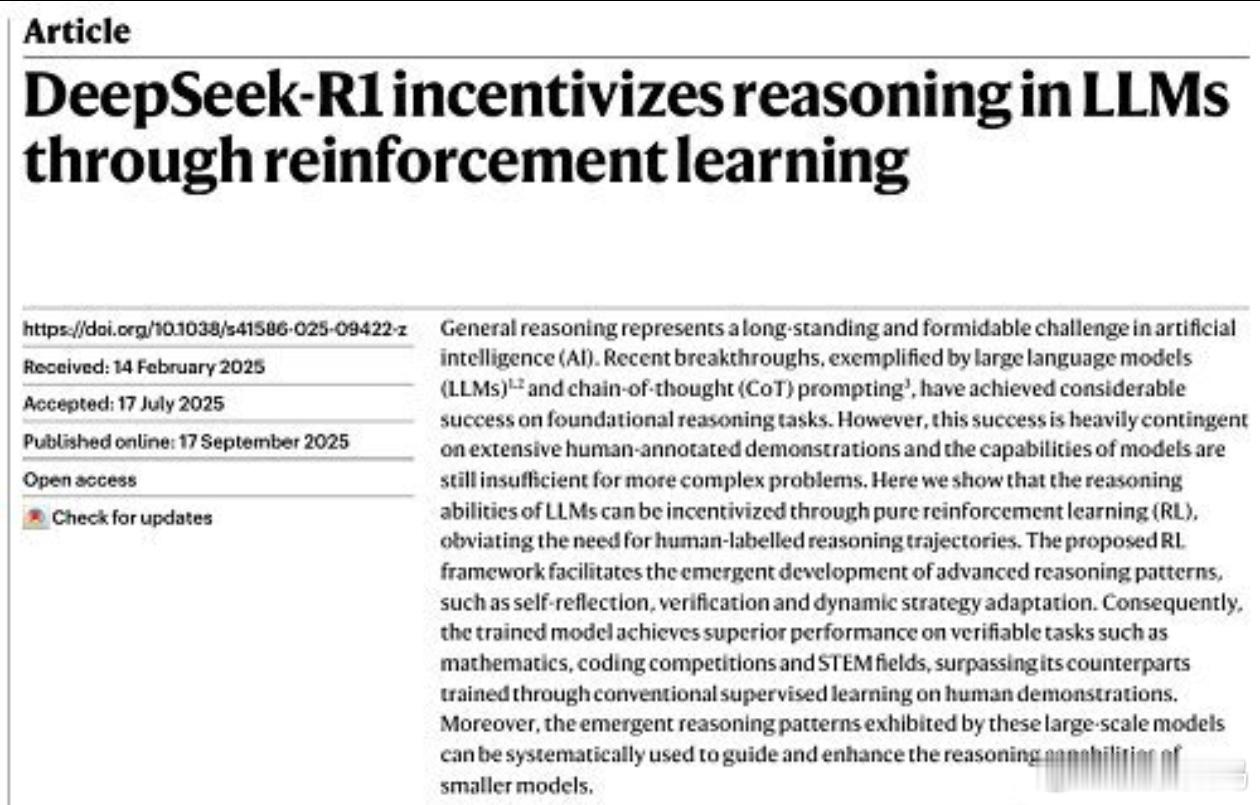

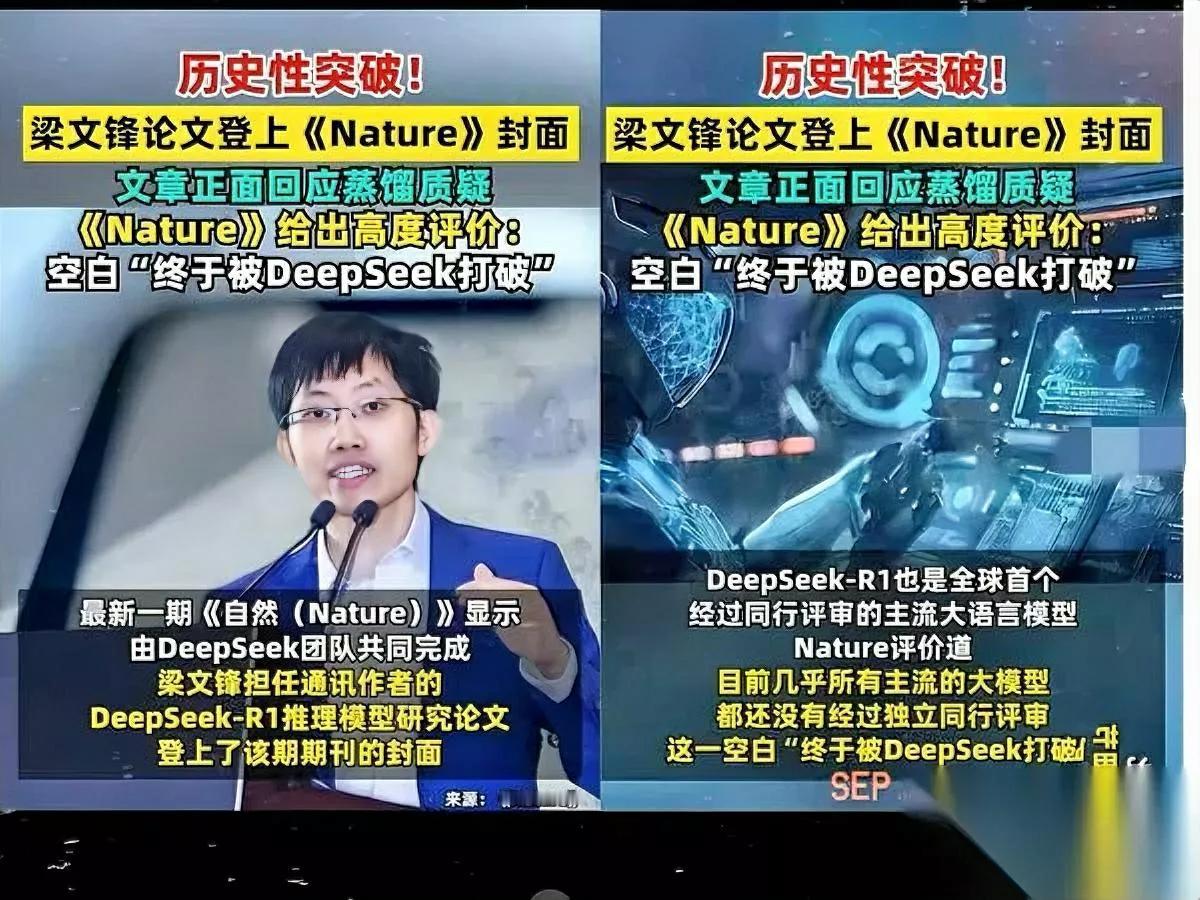

梁文锋发表Nature封面文章 兄弟们,这波直接骑脸输出,把那些天天吹“闭源霸权”的洋大人脸都打肿了。 先说省流版:这波操作相当于你用拼多多的预算做出了苹果的芯片,还他妈开源了!训练成本只要29.4万刀,相当于奥特曼喝杯奶茶的功夫人家就把模型训完了。最骚的是同行评审过程中直接怼脸回应“没用OpenAI数据”。 核心狠活在于他们搞了个纯强化学习路线,让模型自己跟自己玩推理游戏。简单说就是让AI先疯狂脑补解题过程(Think标签),再吐答案(Answer标签),答对了给糖吃,答错了电击伺候。结果这货居然自学了反思、验算甚至“等等我好像错了”的顿悟时刻。传统方法还得人类手把手教解题步骤,DeepSeek直接让AI野性生长,反而憋出了更强的推理能力。 成本控制更是离谱他妈给离谱开门。用512张H800显卡,训R1-Zero花了198小时,R1只用了80小时,折合电费级成本29.4万美元。对比某些公司烧掉几千万刀还藏着掖着,DeepSeek反手把代码和模型权重全开源,相当于麦当劳公开了巨无霸配方还告诉你怎么省油炸薯条。 当然最解气的还是正面刚质疑。之前一堆人bb“肯定偷了GPT数据”,这次Nature论文直接补充实验:用2024年6月前的旧模型当基底,那时还没推理模型,纯靠强化学习照样训出推理能力。评审专家都表示“这反驳比论文还精彩”。 最后不得不提作者列表里那个17岁高中生涂津豪,人家在刷五年高考三年模拟的时候这哥们已经在Nature上署名了。建议教育部连夜修改教材:新课标《如何在高一暑假发表顶刊论文》。 总之这波不仅是中国AI的里程碑,更是给整个行业抽了一鞭子——要么像DeepSeek一样卷透明度和效率,要么等着被开源模型冲烂。 #梁文锋论文登上《自然》封面#