《Embodied AI: From LLMs to World Models》

具身人工智能(Embodied AI)正引领从数字认知向物理智能的跨越,融合大型语言模型(LLMs)与世界模型(WMs),为实现通用人工智能(AGI)奠定坚实基础。

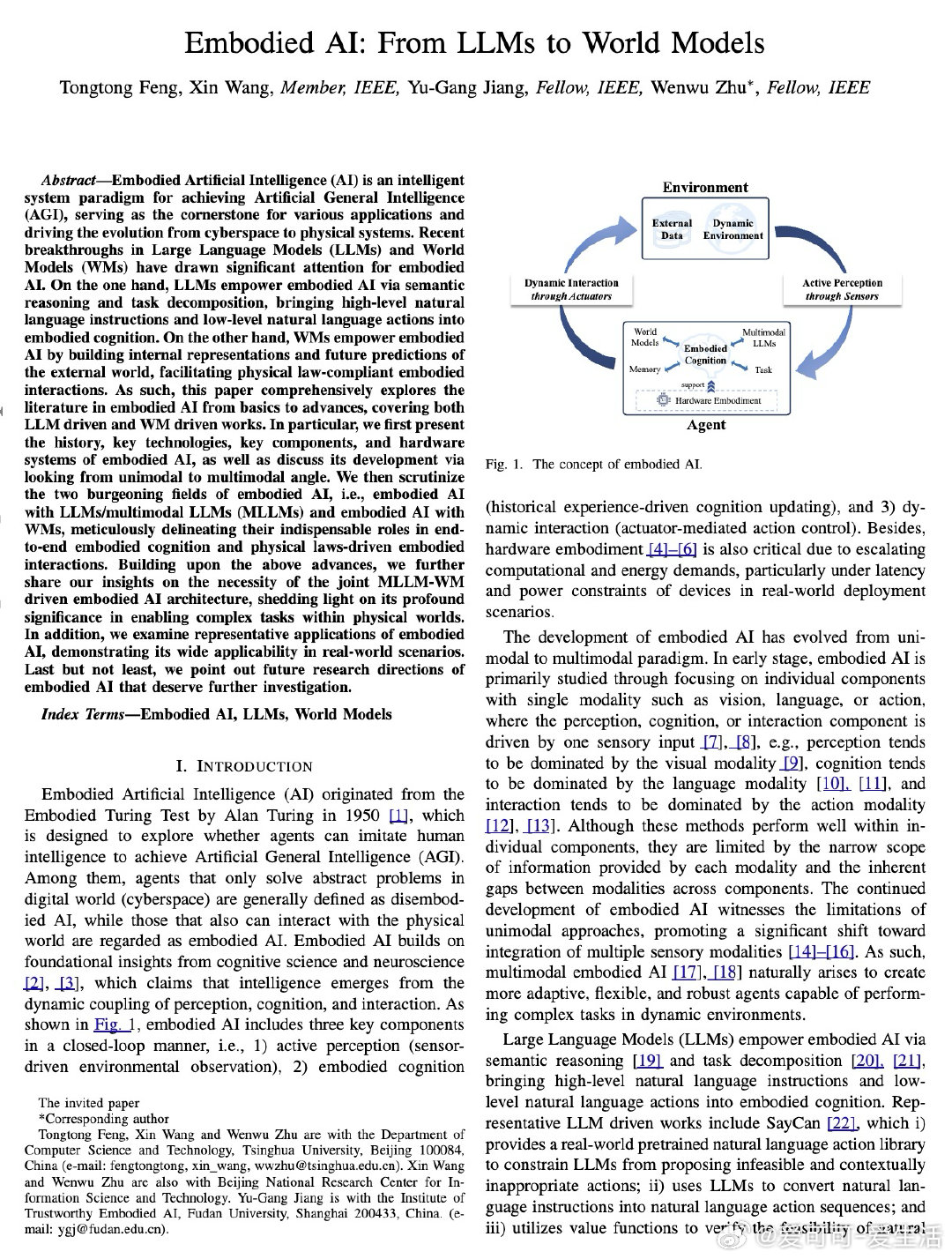

• 具身AI包含主动感知、具身认知和动态交互三大核心环节,通过传感器获取环境信息,经认知模块规划,再由执行机构完成物理动作,形成闭环系统。

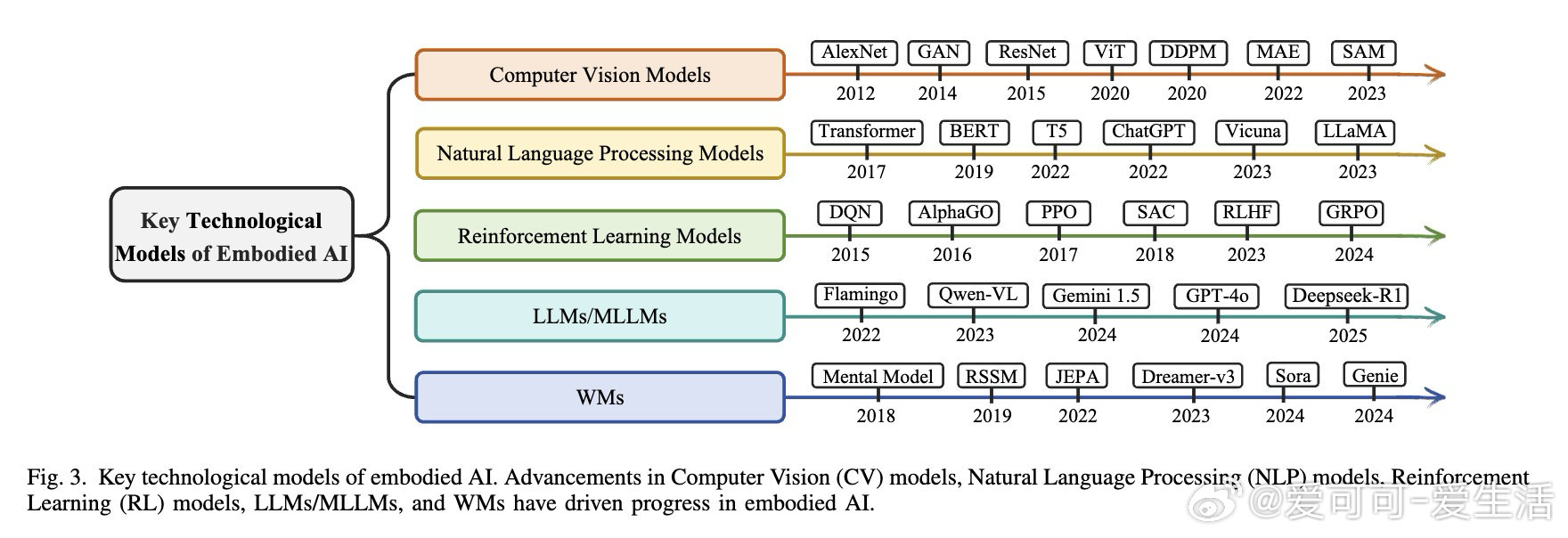

• 发展历程从单模态(视觉、语言或动作)走向多模态融合,突破信息孤岛,实现视觉、听觉、语言、触觉等多感官数据的协同处理,提升环境适应性和任务复杂性处理能力。

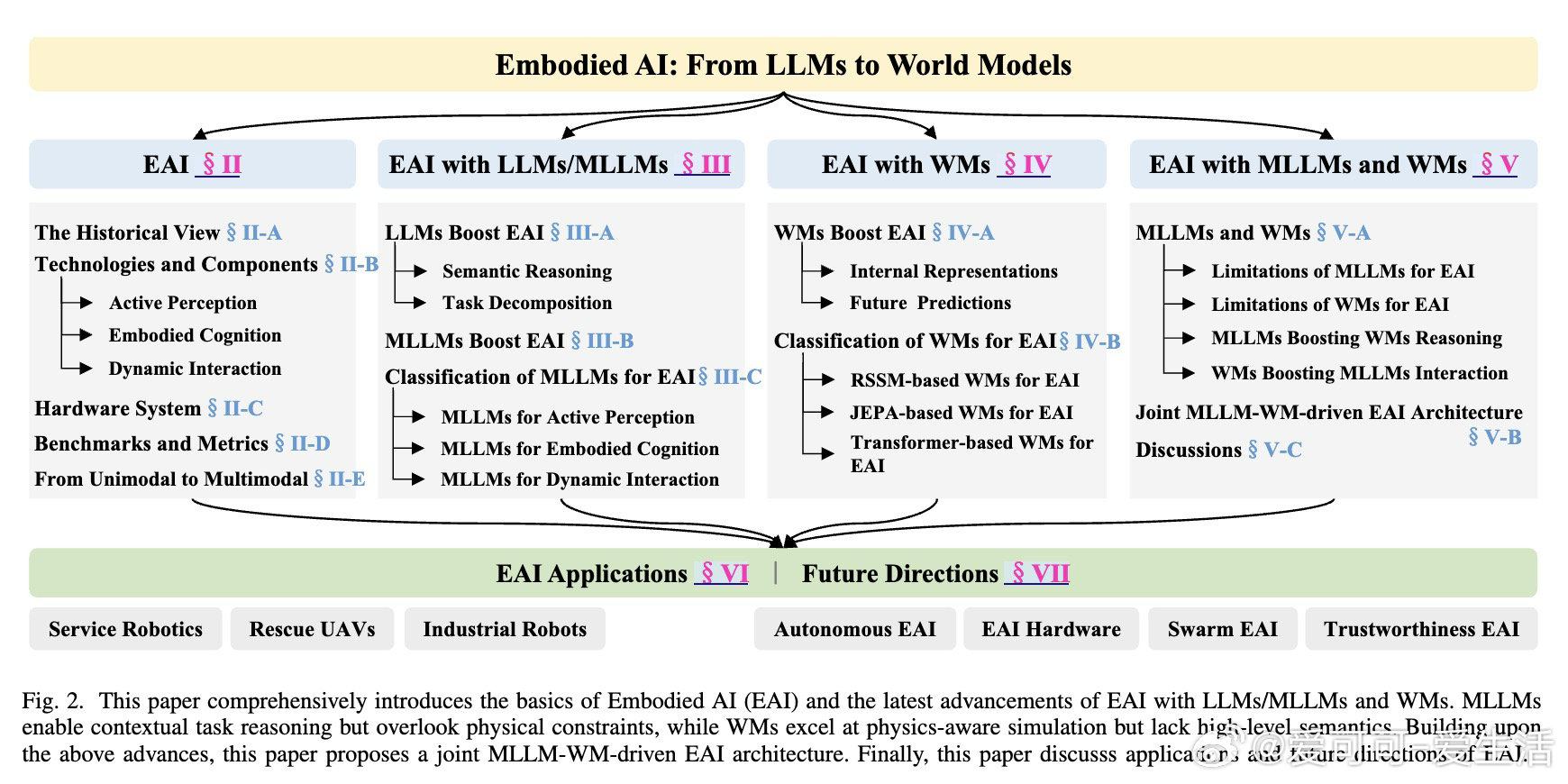

• LLMs驱动的具身AI侧重于语义推理与任务分解,支持将自然语言指令转化为细化子任务,代表作如SayCan,通过结合语言动作库与价值函数,实现合理动作序列生成。

• MLLMs(多模态大语言模型)进阶融合视觉、语言、动作等多模态输入,推动任务规划、环境理解和动态交互的端到端实现,典型模型包括PaLM-E、RT-2等。

• 世界模型为具身AI提供物理世界的内部表征和未来状态预测,支持遵循物理规律的交互决策。关键架构有RSSM、JEPA和Transformer-based模型,强化环境动态建模与多步行为预测。

• 联合MLLM与WM架构弥补单一模型短板,MLLM负责高层语义推理与任务规划,WM负责物理约束模拟与环境状态预测,实现语义与物理的深度耦合,促进复杂场景下的自主决策与执行。

• 具身AI已广泛应用于服务机器人、救援无人机、工业机器人等领域,提升操作灵活性、自主性和环境适应能力,实现从规则驱动到自主学习演进。

• 未来方向聚焦于自主具身系统、多模态感知融合、硬件协同优化、群体智能协作及可解释性与可信赖性,推动具身智能安全可靠地服务复杂现实世界。

心得:

1. 具身AI的本质是认知与物理世界的交织,只有跨模态信息融合与物理规律内化,才能实现真正的环境适应与长期自主。

2. 单纯依赖语言模型或物理模型各有局限,二者互补协同构建的体系结构是解决复杂任务和动态环境挑战的关键。

3. 具身AI不仅是技术集成,更是认知科学、控制理论与硬件设计的深度融合,跨领域协作将催生下一代智能体。

更多详情🔗 arxiv.org/abs/2509.20021

具身人工智能 大型语言模型 世界模型 多模态学习 机器人 人工智能