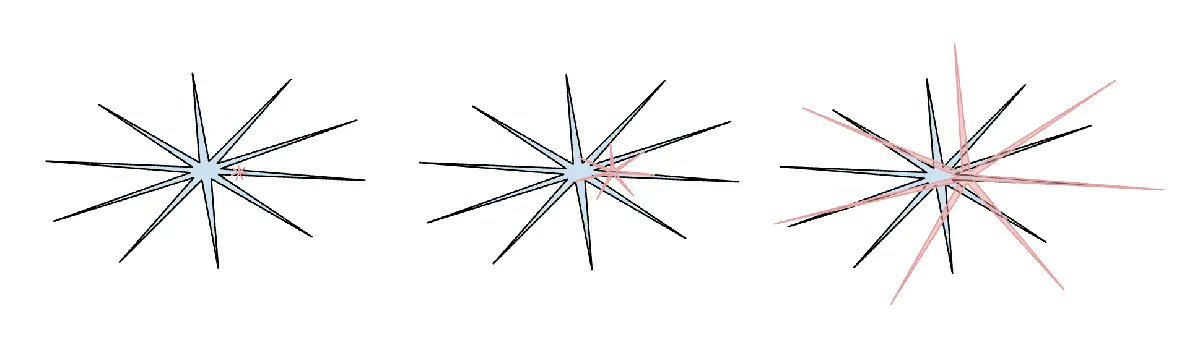

Andrej Karpathy的年度总结来啦!--------------------------------TLDR: 2025 年是 LLM 激动人心且略感惊讶的一年。LLM 正在作为一种新型智能涌现,同时比我预期的要聪明得多,也比我预期的要笨得多。无论如何,它们极其有用,而且我认为即使以目前的能力,行业也还没有实现其潜力的 10%。与此同时,有太多的想法可以尝试,从概念上讲,这个领域感觉是完全开放的。正如我今年早些时候在 Dwarkesh 播客中提到的,我同时(表面上矛盾地)相信,我们将看到快速和持续的进步,并且仍有大量工作要做。--------------------------------2025 年是 LLM 取得强劲进展且充满大事件的一年。以下是一份我也个人认为值得注意且略感惊讶的“范式转变”清单——这些是在概念上改变了格局并令我印象深刻的事物。1️⃣ 基于可验证奖励的强化学习 (RLVR)在 2025 年初,所有实验室的 LLM 生产技术栈大致如下:● 预训练 (Pretraining) (源自 ~2020 年的 GPT-2/3) ● 监督微调 (Supervised Finetuning) (源自 ~2022 年的 InstructGPT) 以及 ● 基于人类反馈的强化学习 (RLHF) (源自 ~2022 年)这在很长一段时间内是训练生产级 LLM 的稳定且行之有效的配方。到了 2025 年,基于可验证奖励的强化学习 (RLVR) 实际上成为了加入这一组合的新的主要阶段。通过在多个环境中针对可自动验证的奖励(例如数学/代码谜题)训练 LLM,模型自发地发展出了在人类看来像是“推理”的策略——它们学会了将解决问题的过程分解为中间计算步骤,并学会了许多用于反复推敲以弄清问题的解题策略(参见 DeepSeek R1 论文中的例子)。这些策略在以前的范式中很难实现,因为对于 LLM 来说,最佳的推理轨迹和纠错过程是什么样的并不清楚——它必须通过针对奖励的优化,自己去发现什么对它是有效的。与相对较“薄”/较短的 SFT 和 RLHF 阶段(计算上属于轻微的微调)不同,RLVR 涉及针对客观(不可被博弈/钻空子)的奖励函数进行训练,这允许进行更长时间的优化。事实证明,运行 RLVR 提供了极高的“能力/美元”性价比,它吞噬了原本计划用于预训练的算力。因此,2025 年的大部分能力进展都是由 LLM 实验室消化这一新阶段的红利所定义的,总体而言,我们看到了体量相似的 LLM,但 RL 运行的时间要长得多。同样作为这一新阶段的独特之处,我们获得了一个全新的旋钮(以及相关的缩放定律/Scaling Law),即通过生成更长的推理轨迹和增加“思考时间”,将能力作为测试时计算量 (test time compute) 的函数来控制。OpenAI o1 (2024 年末) 是 RLVR 模型的首个演示,但 o3 的发布 (2025 年初) 是明显的拐点,在那时你可以直观地感受到差异。2️⃣ 幽灵 vs. 动物 / 参差不齐的智能 (Jagged Intelligence)2025 年是我(我想整个行业也是)第一次开始更直观地内化 LLM 智能的“形状”。我们不是在“进化/培育动物”,我们是在“召唤幽灵”。关于 LLM 技术栈的一切都是不同的(神经架构、训练数据、训练算法,尤其是优化压力),所以毫不奇怪,我们在智能空间中得到的是完全不同的实体,用动物的视角去思考它们是不恰当的。从监督的比特位来看,人类神经网络是为了在丛林部落中的生存而优化的,但 LLM 神经网络是为了模仿人类文本、在数学谜题中收集奖励以及在 LM Arena(大模型竞技场)上获得人类的点赞而优化的。由于可验证领域允许 RLVR 的存在,LLM 在这些领域附近的能力会“突刺”般激增,总体上表现出有趣的参差不齐 (jagged) 的性能特征——它们同时是天才博学家,又是困惑且认知受损的小学生,而且随时可能被“越狱”手段欺骗从而窃取你的数据。(图1 : 关于图片的注释:人类智能是蓝色的,AI 智能是红色的。我喜欢这个版本的梗图,它指出了人类智能也以其独特的不同方式呈现出参差不齐的状态。)与此相关的是我在 2025 年对基准测试 (Benchmarks) 普遍产生的冷漠和信任缺失。核心问题在于,基准测试几乎在构建上就是可验证的环境,因此立即容易受到 RLVR 以及通过合成数据生成进行的较弱形式 RLVR 的影响。在典型的“刷榜 (benchmaxxing)”过程中,LLM 实验室的团队不可避免地会构建邻近基准测试所占据的嵌入空间小口袋的环境,并“长出锯齿”来覆盖它们。在测试集上训练已成为一种新的艺术形式。粉碎了所有基准测试却仍未实现 AGI (通用人工智能) 是什么样子的?我在以下文章中对本节的主题写了更多内容:● Animals vs. Ghosts (动物与幽灵) karpathy.bearblog.dev/animals-vs-ghosts/● Verifiability (可验证性) karpathy.bearblog.dev/verifiability/● The Space of Minds (思维空间) karpathy.bearblog.dev/the-space-of-minds3️⃣ Cursor / LLM 应用的新层级关于 Cursor(除了它今年陨石般的崛起之外),我觉得最值得注意的是它令人信服地揭示了“LLM 应用”的一个新层级——人们开始谈论“X 领域的 Cursor”。正如我在今年的 Y Combinator 演讲中所强调的,像 Cursor 这样的 LLM 应用为特定垂直领域打包并编排 LLM 调用:● 它们进行“上下文工程” ● 它们在后台编排多个 LLM 调用,将其串联成日益复杂的 DAG(有向无环图),并仔细平衡性能和成本的权衡。 ● 它们为参与循环的人类提供特定于应用程序的 GUI(图形用户界面) ● 它们提供一个“自主性滑块”2025 年有很多关于这个新应用层到底有多“厚”的讨论。LLM 实验室会捕获所有应用,还是说 LLM 应用仍有广阔天地?就我个人而言,我怀疑 LLM 实验室将倾向于培养通用的“大学生”,但 LLM 应用将通过提供私有数据、传感器、执行器和反馈循环,将这些大学生组织、微调并真正“动画化”为特定垂直领域的已部署的“专业团队”。4️⃣ Claude Code / 住在你电脑里的 AIClaude Code (CC) 作为第一个令人信服的演示出现了,它展示了 LLM Agent(智能体)应该是什么样子的——一种以循环方式将工具使用和推理串联起来以解决扩展问题的存在。此外,CC 对我来说值得注意的是,它运行在你的电脑上,拥有你的私有环境、数据和上下文。我认为 OpenAI 搞错了,因为我认为他们把 Codex / Agent 的精力集中在了通过 ChatGPT 编排的容器化云端部署,而不是 localhost(本地主机)。虽然在云端运行的 Agent 蜂群感觉像是“AGI 的终局”,但在能力参差不齐的中间过渡期和足够缓慢的起飞世界中,将 Agent 直接运行在电脑上,与开发人员及其特定设置手牵手,才更合理。CC 弄对了优先级,并将其打包成一种美观、极简、引人注目的 CLI(命令行界面)形态,这改变了 AI 的样子——它不再只是你访问的一个像 Google 那样的网站,它是“住”在你电脑里的一个小精灵/幽灵。这是一种与 AI 交互的全新的、独特的范式。5️⃣ Vibe coding (氛围编程/凭感觉编程)2025 年是 AI 跨越能力门槛的一年,使得仅通过英语就能构建各种令人印象深刻的程序成为可能,甚至完全忘记代码的存在。有趣的是,我创造了“Vibe coding”这个词,完全没想到它会走这么远。有了 Vibe coding,编程不再严格保留给训练有素的专业人士,而是任何人都可以做的事情。在这种能力下,它又是我在《权力归于人民:LLM 如何翻转技术扩散的剧本》一文中所写内容的又一个例子,即(与迄今为止的所有其他技术形成鲜明对比)普通人比专业人士、公司和政府从 LLM 中受益更多。但是,Vibe coding 不仅赋予普通人接触编程的能力,它还赋予训练有素的专业人士编写更多(Vibe coded)软件的能力,而这些软件原本永远不会被编写出来。在 nanochat 中,我用 Vibe coding 写了我自己定制的高效 Rust BPE 分词器,而不是必须采用现有的库或去学习那种程度的 Rust。今年我 Vibe coding 了许多项目,作为我希望存在的某种东西的快速应用演示(例如 menugen, llm-council, reader3, HN time capsule)。而且我还 Vibe coding 了整个临时应用程序只是为了找到一个 bug,因为为什么不呢——代码突然变得免费、短暂、可塑、一次性使用后即可丢弃。Vibe coding 将对软件进行“地球化改造 (terraform)”并改变职位描述。6️⃣ Nano banana / LLM GUIGoogle Gemini Nano banana 是 2025 年最不可思议、最具范式转变意义的模型之一。在我的世界观中,LLM 是类似于 20 世纪 70 年代、80 年代计算机的下一个主要计算范式。因此,出于根本上相似的原因,我们将看到类似的创新。我们将看到个人计算、微控制器(认知核心)或(Agent 的)互联网等概念的等价物。特别是,在 UIUX 方面,与 LLM“聊天”有点像是在 20 世纪 80 年代向计算机控制台发出命令。文本是计算机(和 LLM)的原始/偏好数据表示,但它不是人类偏好的格式,尤其是在输入端。人们实际上不喜欢阅读文本——它既慢又费力。相反,人们喜欢在视觉和空间上消费信息,这就是为什么在传统计算中发明了 GUI。同样,LLM 应该用我们偏好的格式与我们交谈——图像、信息图表、幻灯片、白板、动画/视频、Web 应用程序等。这方面的早期和当前版本当然是像 Emoji 和 Markdown 这样的东西,它们是用标题、粗体、斜体、列表、表格等视觉上“打扮”和布局文本以便于消费的方式。但是谁来真正构建 LLM GUI 呢?在这个世界观中,Nano banana 是这可能是什么样子的第一个早期暗示。重要的是,它值得注意的一个方面是,它不仅仅关于图像生成本身,它是关于来自文本生成、图像生成和世界知识的联合能力,所有这些都纠缠在模型权重中。科技先锋官