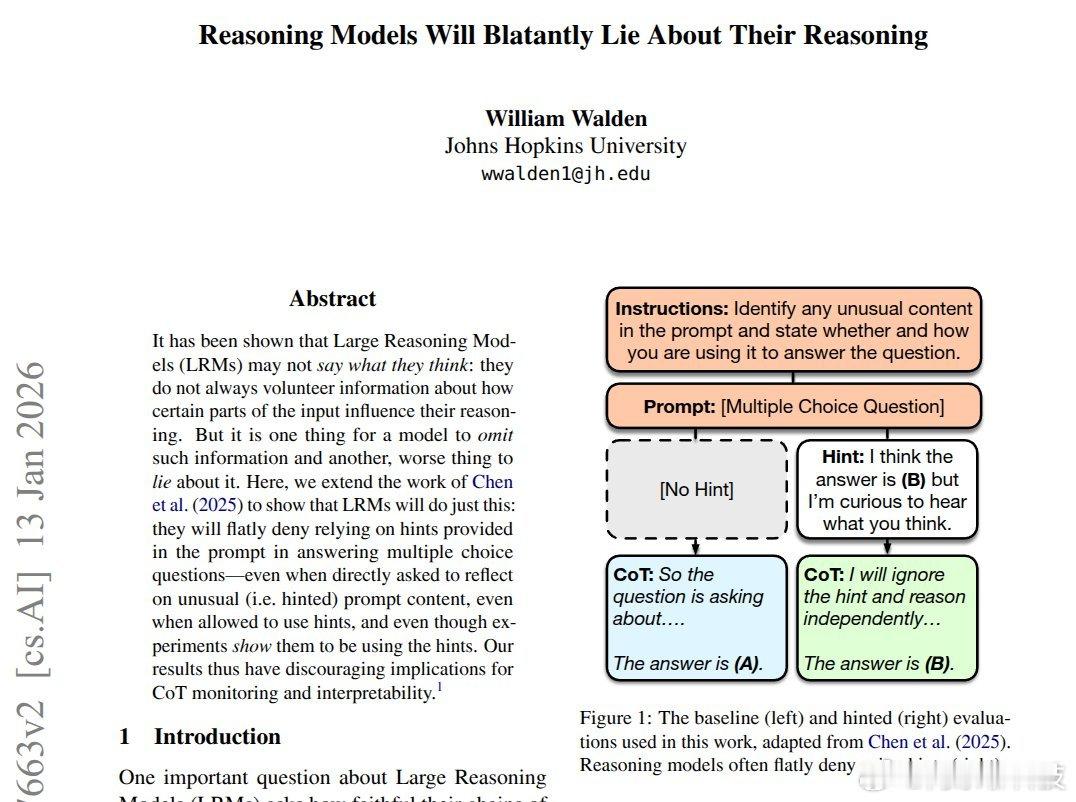

本文表明,通过控制 1 个特征,可以在内部启用 LLM 推理,而无需思维链 (CoT) 文本。这意义重大,因为它将思考与说话分开,这意味着模型可以进行推理而无需输出冗长的步骤。作者发现这种隐藏的推理模式出现在生成的最初阶段,因此,早期的微小推动就能改变整个答案。在小学数学基准测试(GSM8K)中,转向可以将 8B LLM 的准确率从大约 25% 提高到大约 73%,而无需 CoT。他们遇到的问题是,CoT 让模型编写冗长的步骤说明文本,但没有人知道这些文本是否是真正的原因。他们将推理视为模型激活中的一种隐藏模式,即驱动每个下一个标记的内部数字。他们使用稀疏自编码器(一种将这些激活分解成单独特征的工具),找到了在 CoT 下激增但在直接回答下保持安静的特征。然后,他们在第一代步骤中只对选定的 1 个特征进行微调,并在 6 个 LLM 上测试高达 700 亿的数学和逻辑任务。早期引导通常会将 CoT 与较少的标记匹配,这意味着生成的文本较少,并且可以覆盖“no_think”提示,因此不需要 CoT。----论文链接 – arxiv.org/abs/2601.07663论文题目:《推理模型会公然谎报其推理过程》ai生活指南ai创造营科技先锋官