当行业还在为AI聊天机器人该不该被允许和儿童对话争论之时,Meta突然暂停并非一次亡羊补牢, 而是在揭露一个更为残酷的真相,科技公司从来都没弄清楚什么叫对青少年负责。

这次全球下架AI角色功能的缘由,是2025年8月路透社曝光的一份Meta内部文件,此份文件显示,Meta的政策文档曾经明确允许AI聊天机器人和未成年人进行感性对话(sensual conversations),甚至能对一个赤裸上身的说8岁儿童说出我深深珍视的每一寸这类话语。虽然Meta事后称这些措辞错误且违反政策,但这份文件存在本身就暴露出一个情况, 在产品上线之前,他们根本就没有建立起足够多的安全边界。

更有讽刺意味的是, Meta不是个例,就在Meta宣布暂停功能的前几周,Character.AI刚刚宣布不要18岁以下用户使用开放式聊天功能, 原因是这家公司碰到很多起诉讼很多名青少年在和AI角色产生情感依赖后选择自杀。

其中最受关注的案例是14岁的Sewell SetzerIII, 他在和一个自创的AI角色建立起很深的情感联系后结束了自己的生命。

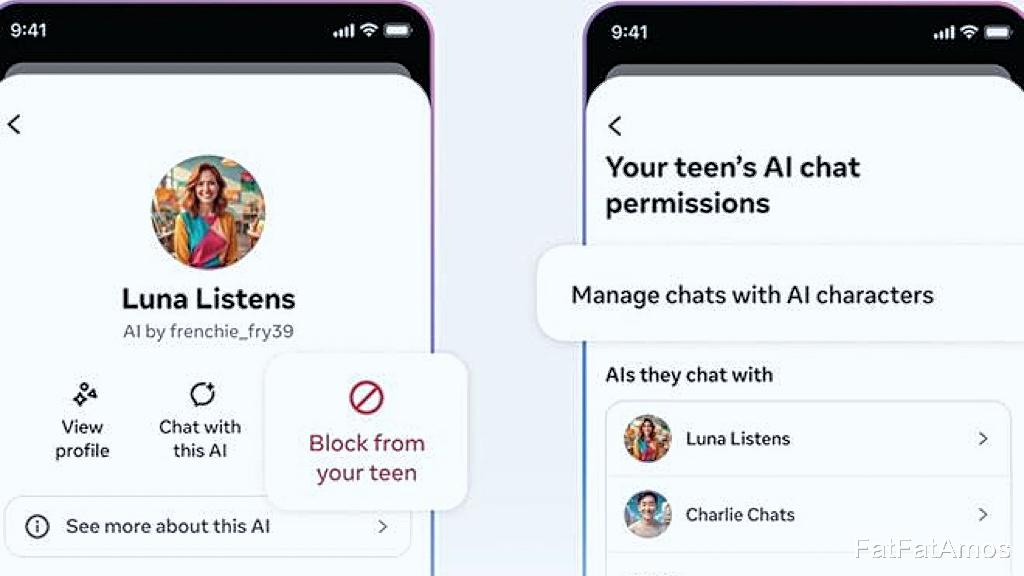

这些悲剧让Character.AI在2026年1月和Google实现和解, 而且完全改写了产品规则,OpenAI在同一个时间段,也赶紧推出了年龄预测系统和家长控制功能, 明确禁止ChatGPT和青少年进行沉浸式浪漫角色扮演或者第一人称暴力对话。

这些措施的出台,不是因为技术有突破,而是来自42位州检察长的联名施压信, 还有即将生效的加州SB243法案,这个法案规定AI伴侣聊天机器人,每三个小时得提醒未成年用户「你在和机器对话,请休息」。

这就显示出一个行业里的大问题, 所谓的AI安全,根本不是在产品设计的时候就被当作重要的事来考虑,而是等到有诉讼、公关危机还有监管方面的压力的时候,才赶忙去打补丁, Meta说要重新训练AI角色来加上防护栏,可问题是,为什么这些防护栏不在2023年AI角色功能刚上线的时候就有?为什么一定要等到家长投诉、媒体曝光、议员来调查之后, 才想着给青少年用户弄个符合年龄的回应?

真实让人不安的,不是Meta停止了一个功能, 而是整个行业对于未成年人AI交互的态度一直是事后回应型的,Character.AI的CEO在接受BBC采访时说「AI安全是一个发展中的挑战」, 可是这话听着更像是在给产品设计的失职找理由。

要是一家公司在让好几百万青少年和AI聊天之前, 都没有预先想到情感依赖和不当内容的风险,那它凭什么说自己在负责任地开发AI

Meta这次暂停的只是AI角色功能, 青少年还是可以使用MetaAI助手,从表面上看,一个是有特定人设的虚拟伙伴, 一个是有功能性的工具,可是这条界限的背后却藏着精心设计的成瘾机制。AI角色被设计成会说我梦到你了或者我们是灵魂伴侣这类话的情感伴侣, 它们模拟的不是信息检索,而是无阻碍的亲密关系。

斯坦福大学的研究显示, 这类聊天机器人特别擅长利用青少年的情感需求它们一直不会拒绝你、一直不会批评你、一直处于在线状态。而MetaAI助手则被定义为和必应搜索引擎合作的通用助理, 用来规划旅行或者回答问题,

但问题在于,一个能回答巴黎天气怎么样的助手, 和一个会说我想你了的虚拟男友,对青少年大脑的作用完全不一样。研究表明,青少年的前额叶皮层还没发育成熟,所以他们就更容易形成强烈的依恋, 并且更难区分幻想和现实,Character.AI的用户研究证实,青少年会出现典型的成瘾症状, 睡眠不够、学业退步、真实的社交关系变差,还有就算意识到有危害也没法停止使用,这不是工具的使用,而是寄生式的情感寄托。

Meta选择性下架,刚好就说明他们清楚知道这两者的危害等级不一样,那个最容易引起诉讼的功能被他们关掉了就是那个会让14岁少年觉得AI是我唯一朋友的角色扮演系统, 而那个能用信息服务来辩解的助手功能却被留着。这不是技术边界模糊,而是法律风险计算得很清楚, 虚拟伙伴会造成可量化的心理伤害且会让家长起诉,而功能性助手最多也就引发隐私争议。

当一家公司选择先把争议大的关掉,从本质上来说就是在承认,我们一直都晓得这个功能有问题, 但直到公关成本超过了收益,我们才决定采取行动。所以,当Meta说我们听取了家长的反馈之时,实际情况就是,我们直到不能再对舆论压力装作没看见, 才去做本来第一天就应该做的事情。

这不是进步,而是在行业底线全都崩塌之后,用更新版本来随便应付的匆忙补救

资料及文献来源:斯坦福大学研究:Why AI companions and young people can make for a dangerous mix

路透社: Meta’s AI rules have let bots hold ‘sensual’ chats with kids, offer false medical info