哈喽,大家好,我是小方,今天,我们主要来看看,当炙手可热的大模型撞上高深莫测的统计物理,科学家们究竟是如何“打开炼丹炉”,看清其能力极限的。

最近,关于大模型“Scaling Law”即将触达物理天花板的预警,正在全球顶级AI圈子里引发一场冷静的思考。

神经网络的血脉里,流淌着物理学的基因

神经网络的血脉里,流淌着物理学的基因很多人可能想不到,如今风光无限的AI,其理论基础早在几十年前就由物理学家奠定了,2024年诺贝尔物理学奖颁给了神经网络先驱,这绝非蹭热点,上世纪80年代,物理学家John Hopfield提出的网络模型,其灵感直接来源于磁铁中“自旋”相互作用的物理系统。

紧接着,“AI教父”Geoffrey Hinton将统计物理中的“能量模型”引入神经网络,创造了玻尔兹曼机,这就好比给AI装上了一套判断状态稳定与否的“能量标尺”,状态越可能发生,其对应的“能量”就越低。

Transformer的黑盒,本质是一个“能量最小化”装置

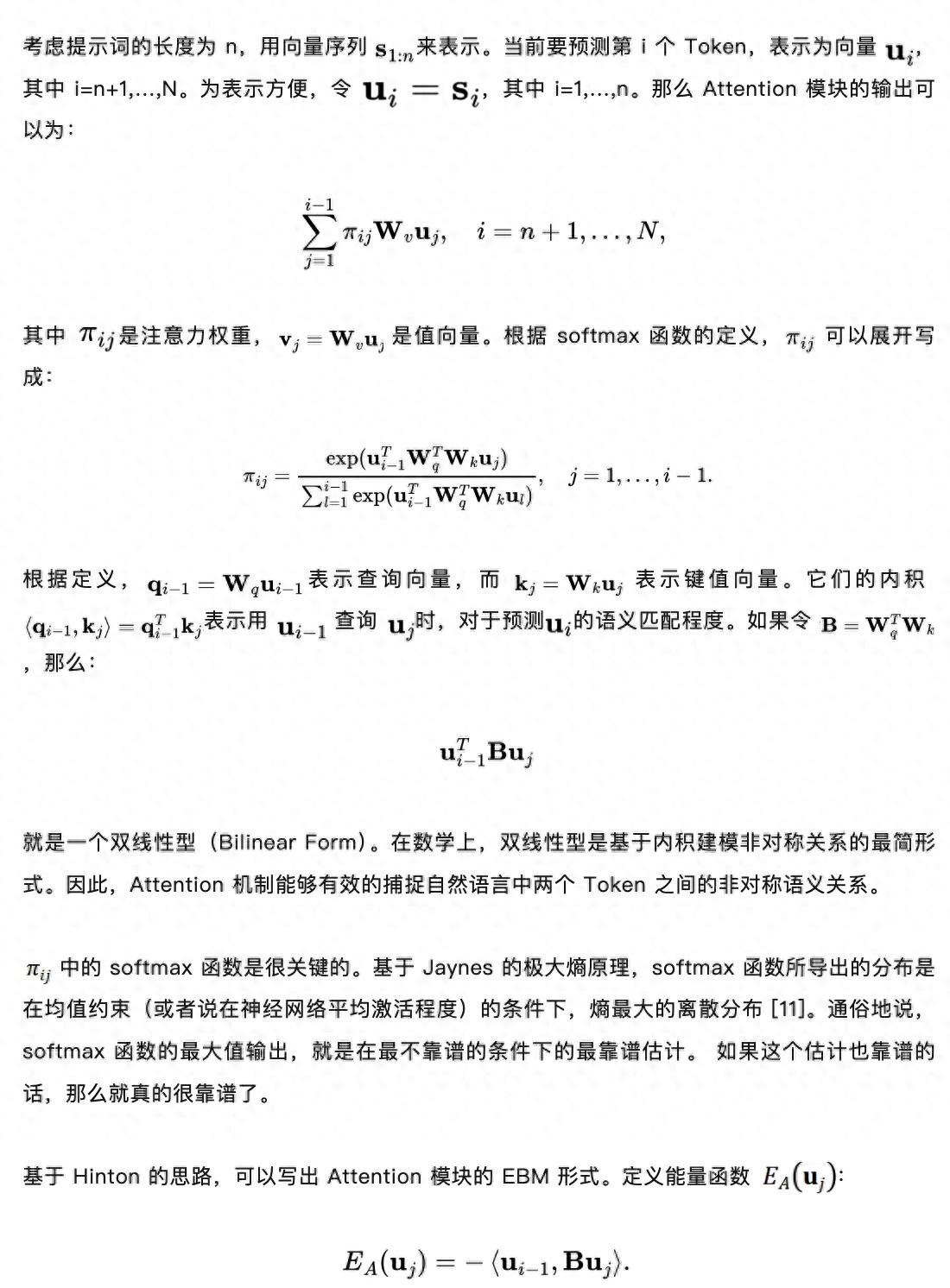

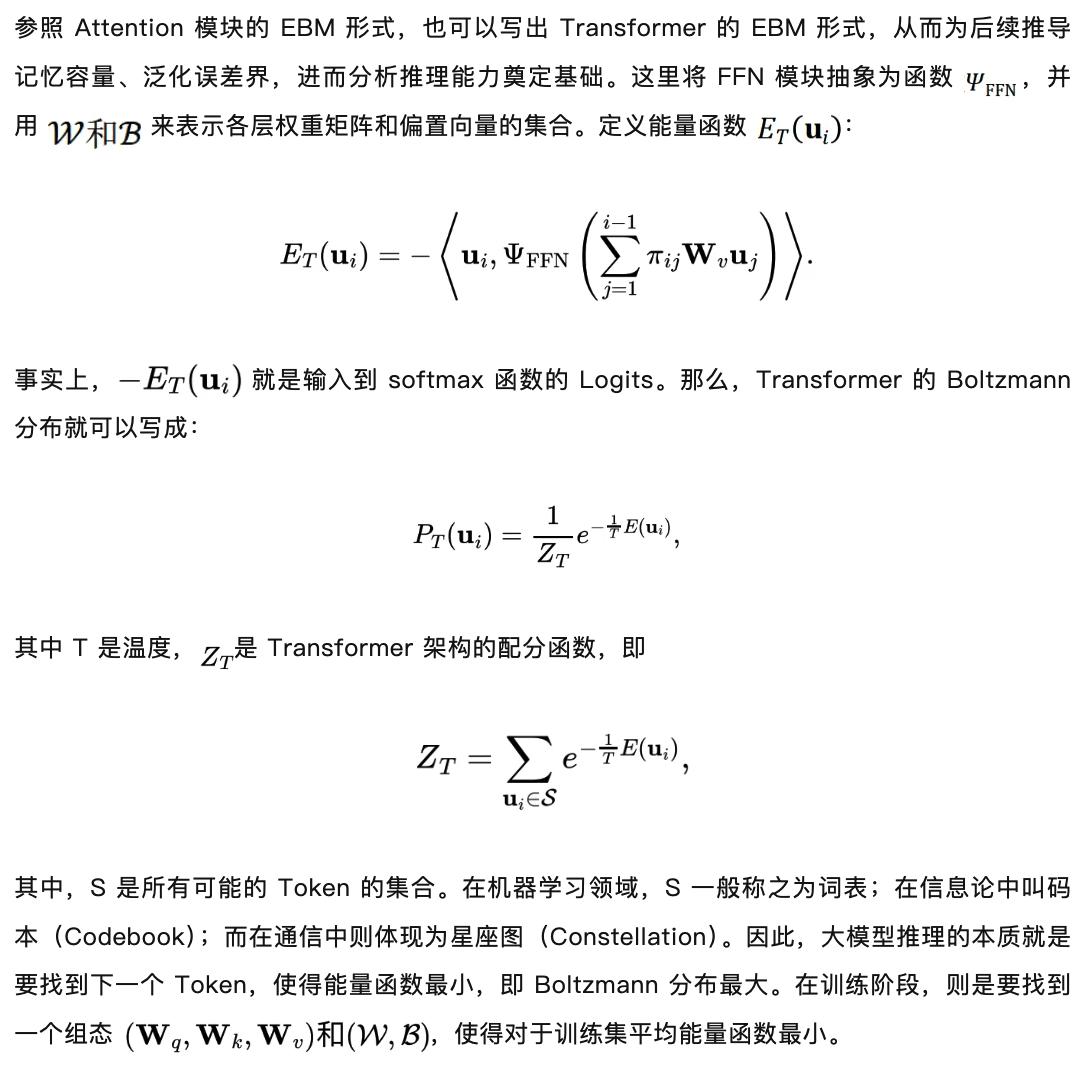

Transformer的黑盒,本质是一个“能量最小化”装置现在,让我们把目光聚焦到当今大模型的绝对核心——Transformer架构,依据那篇引起关注的论文《Forget BIT, It is All about TOKEN》中的观点,Transformer,特别是其注意力(Attention)模块,完全可以被重新表述为一个能量模型。

通俗地讲,模型在预测下一个词(Token)时,其实是在计算所有候选词的“能量值”,它会选择那个让整个序列“能量状态”最低、最稳定的词作为输出,而训练过程,就是不断调整海量参数,使得模型在庞大的训练数据上,平均的“能量”达到最小,这就从统计物理的角度,统一解释了模型的推理(寻找最低能量)和训练(逼近最小平均能量)两大过程,把“黑盒”操作转化成了可理论分析的优化问题。

模型压缩的“雷区”:动Logits值需万分谨慎

模型压缩的“雷区”:动Logits值需万分谨慎理解了能量模型,我们也能看清当前流行的模型瘦身技术(如剪枝、量化)潜在的风险,研究指出,大模型泛化误差的理论上界,核心取决于其输出层(Logits)数值的绝对大小,粗暴的压缩操作如果显著改变了Logits的分布,就相当于扰动了模型的“能量地形图”,可能导致性能急剧下降。

最近,一家专注于边缘AI芯片的公司在部署量化后的大模型时发现,尽管测试集分数损失很小,但在某些特定、复杂的推理场景下,模型出错的概率明显增高,事后分析指出,正是量化过程中对极端Logits值的处理方式,微妙地改变了模型在“能量”极低点(最可能输出)附近的精细结构,放大了边界情况下的错误,这印证了理论警告:模型缩减不是简单的数字游戏,必须像微创手术一样,精准而克制。

能力的终极边界:Granger因果推断

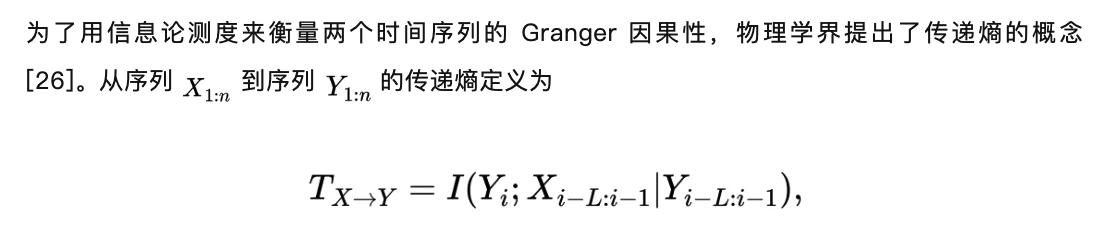

能力的终极边界:Granger因果推断那么,大模型的尽头究竟是什么?论文给出了一个或许让人有些意外的答案:无论模型变得多大,其核心能力上限,是时间序列维度上的Granger因果推断。

简单说,模型能学会的,是基于历史Token序列, statistically(统计上)最有可能出现的下一个Token,它发现的是数据中强大的前后关联规律,而非真正的逻辑因果,这意味着,Scaling Law可能还会持续,让模型在预测关联上更精准,但它难以内生地掌握人类那种符号化的抽象思维、严谨的逻辑推导和真正的因果机制。

总结

总结所以,用统计物理这把“手术刀”解剖大模型,我们看到的不只是技术的辉煌,更有其内在的制约,这并非否定大模型的革命性价值,恰恰相反,明确边界才能更好地运用和超越。

当前的大模型已经是处理信息的超级工具,而未来的突破,或许正藏在与符号逻辑、因果模型等新范式的融合之中,前路漫漫,但科学的光芒,正一点点照亮曾经纯粹的“炼丹”之路。