上海人工智能研究院数字化治理中心主任彭嘉昊在接受国内媒体采访时表示,我们目前的芯片擅长推理,也就是应用层面。但是在大模型的训练上面,我们与美国英伟达产品的差距很大,尤其是在单卡性能上面,我们的昇腾910B差不多能达到英伟达A100的算力,相当于美国5年前的水平。

我们的策略就是正视在技术层面的差距,通过计算集群和超节点的技术策略来弥补单卡性能上面的差异。如果仅仅只是在应用层面,那我们目前已经可以解决很多急需解决的问题,例如涉及到民生领域的应用问题,我们可以实现国产替代,但是在最前沿的模型训练领域,我们还在追赶的过程中。

超节点技术

超节点技术根据中科院物理研究所发布的资料显示,ai产业当中有一个技术概念叫做超节点,超节点就相当于把Scale Up(向上扩展)和Scale Out(向外扩展)结合在一起,提升整体的性能和大模型训练推理的效率。

Scale Up指的是硬件为主,在算力不够的情况下,通过添加更多的GPU和内存提升单个设备的性能。

Scale Out指的是协同工作,在单个设备性能不足的情况下,将多个同样性能的设备联合在一起,通过协同工作来提升性能。

超节点将两者的概念融合,将多个设备通过技术手段进行深度协同使其在逻辑层面表现为一台统一的设备,从而提升整体的算力性能。

参考资料:

这个技术最早是由英伟达公司提出的概念,2024年英伟达发布了NVL72,NVL72将36个Grace CPU和72个Blackwell GPU集成到一个液冷机柜中,实现总计720 PFLOPs的稀疏FP8计算性能,或1440 PFLOPs的推理性能。并且英伟达的超节点技术为私有协议,其他厂商无法直接使用。

2025年,华为推出了CloudMatrix 384超节点技术,该技术与英伟达一样均为私有协议,用384张昇腾算力卡和192颗鲲鹏芯片组成超节点,在目前已商用的超节点中单体规模最大,可提供高达300 PFLOPs的密集BF16算力,接近达到英伟达GB200 NVL72系统的两倍。

在国产单卡芯片较为落后的情况下,通过超节点技术可以有效填补当下产业发展的真空期,推动国内ai产业在应用推理层面继续向前发展,持续优化技术。

并且中国成熟完善的资源建设体系,足以支撑起国内多个大规模数据中心的运行。华为的CloudMatrix 384超节点已经在乌兰察布、贵安、芜湖等三个地方完成了规模化部署,支撑起超过160个第三方大模型的训练推理,并同步适配了Deep Seek等模型的应用场景。产业资源的优势,成为了中国发展ai技术的核心力量。

技术优化在受到美国的全面封锁之后,中国企业就开始将目光转向技术优化策略。一边通过技术优化提升整体性能,一边深度联合产业链对卡脖子的困境进行突围。

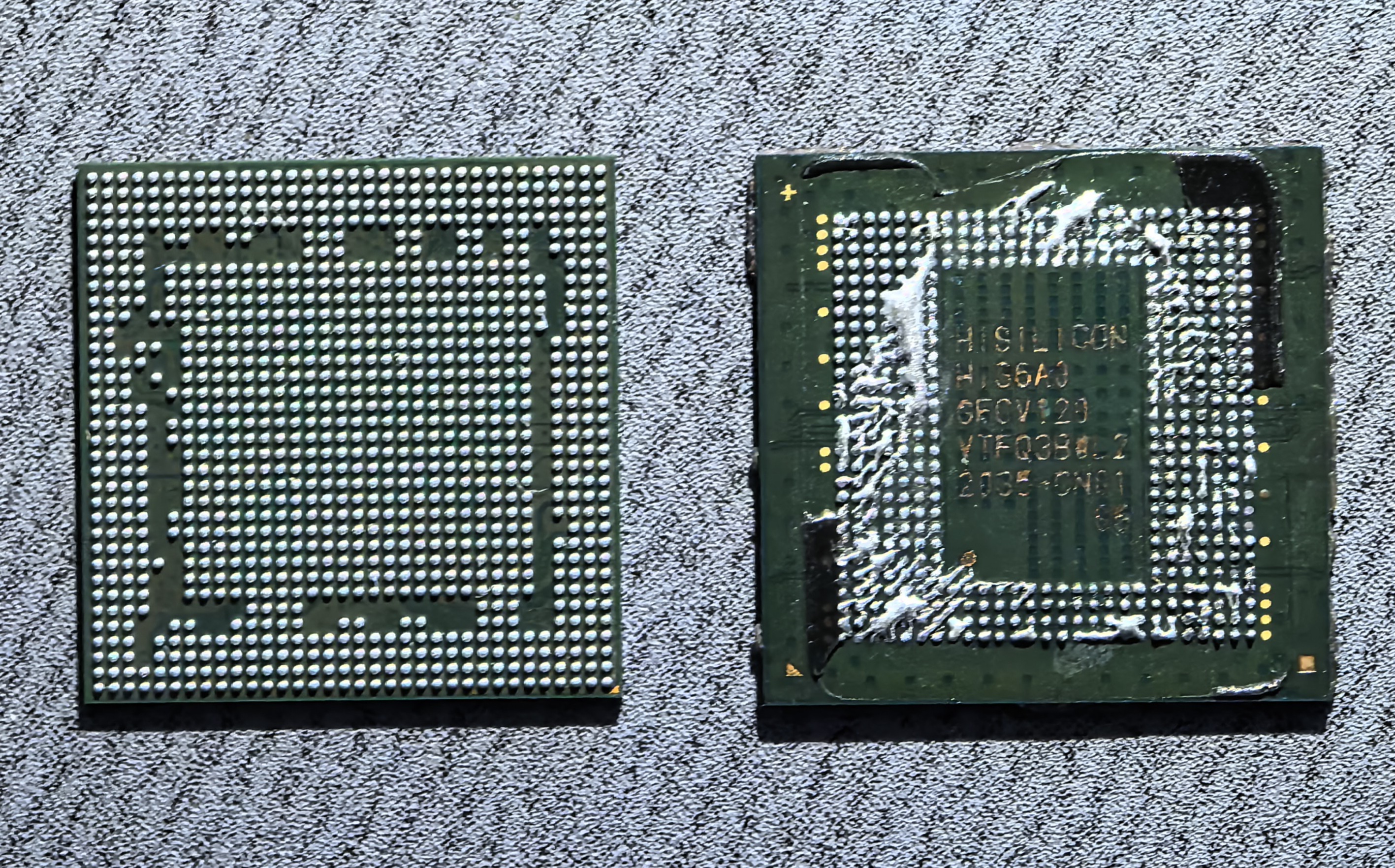

除上述提到的超节点技术之外,在被美国出口管制期间,最早一批通过技术优化实现性能提升的产品可以追溯到华为的麒麟9000S,然后就是Deep Seek。

麒麟9000S的等效工艺为7nm,采用浸润式DUV光刻机和自对准多重图案化制造完成。其内部CPU的大中核心为华为自研的泰山架构,小核心采用了ARM提供的A510,支持8核12线程的超线程技术。

在此之前,超线程技术一直被用在X86架构的PC领域,麒麟9000S是行业内第一款支持超线程的ARM芯片。

在同等工艺下,想要提升性能无非两种方法,超频和超线程。

超频就是单纯拉高芯片的CPU频率,以此来获得更好的性能表现。对比未超频的CPU,想要完全发挥出超频技术的作用,需要保持在一个较高负载的场景下。而超线程虽然也可以带来性能上的提升,但提升的性能跟功耗基本持平,适合应用在多任务场景中。

超线程适用于PC行业,个人电脑的体积较大,并且散热效率更高,可以承担超线程技术所带来的功耗提升。而手机产品由于尺寸较小,内部空间有限,所以对于功耗特别敏感。相对于超线程技术,直接给手机CPU超频是更加合适的方案。

但是受限于美国的制裁封锁,麒麟9000S采用了超线程技术,为了尽可能压制超线程所带来的温度上升,华为在mate60系列的屏幕后面又加入了一大块均热板。华为后续的芯片升级,均可以看做是基于麒麟9000S进行的全方位超频。

Deep Seek也是如此,通过对特定的场景进行针对性训练,用较少的技术成本实现了比肩GPT的算力性能。在先进光刻机的问题没有得到有效解决之前,这种用技术优化来稳步提升芯片性能的思路,是当下中国企业重点推进的方向。