距离亚马逊网络服务(AWS)发布其下一代Trainium AI加速器Trainium3已经快一年了。现在芯片正式到货。在AWS re:Invent上,该公司宣布正式推出Amazon EC2 Trn3 UltraServers,这是第一个围绕新芯片构建的系统,是其弹性计算云服务的一部分。

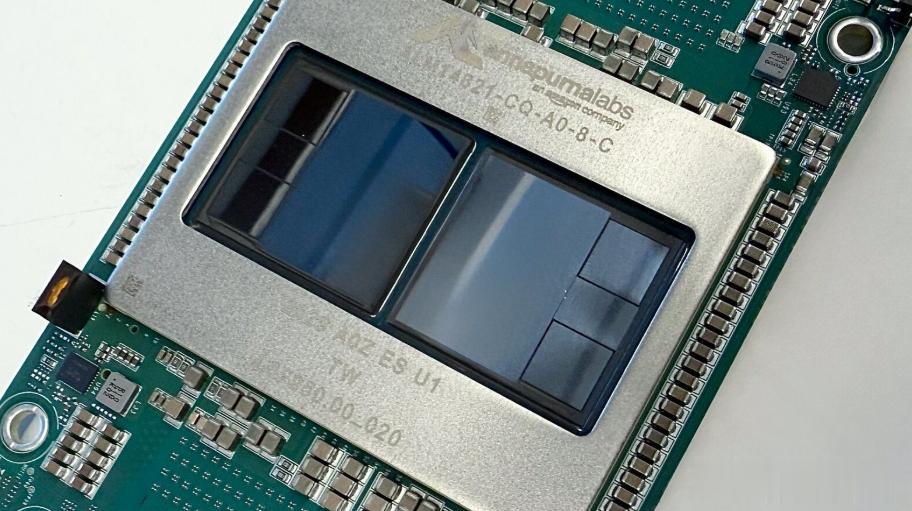

Trainium3由台积电基于3-nm工艺构建,每个芯片可提供2.52 PFLOP的FP8计算能力。该设备集成了144 GB的HBM3e内存,提供4.9 TB/s的内存带宽。高算力得益于架构变化,平衡了现代人工智能工作负载的计算、内存和数据移动。该公司表示,Trainium3增加了对FP32、BF16、MXFP8和MXFP4的支持,并增强了对结构化稀疏性、微尺度、随机舍入和集体通信引擎的硬件支持。该公司表示,这些新增功能旨在使芯片更好地与LLM的训练模式、专家架构的混合和多模态系统相匹配。

改进概述了硅级别的新功能,但AWS表示,真正的价值规模来自Trainium3的部署方式。该公司指出,许多最大的性能和效率提升出现在UltraServer级别,其中新的结构、内存拓扑和集体引擎在数百个芯片上运行。在系统级别,一个完全配置的Trainium3 UltraServer连接了144个芯片,聚合了362个FP8 PFLOP、20.7 TB的封装内HBM3e和706 TB/s的内存带宽。根据AWS的数据,该系统的计算性能提高了4.4倍,能效提高了4倍,内存带宽增加了近4倍。这些数字基于该公司发布博客中分享的AWS内部测量数据。

Trainium3还推出了NeuronSwitch-v1,“这是一种新的全对全结构,在单个UltraServer中连接多达144个芯片,与Trn2 UltraServers相比,芯片间带宽加倍。”该公司还强调了其网络堆栈的改进:升级后的Neuron fabric将芯片到芯片的通信延迟降低到“不到10微秒”,而EC2 UltraClusters 3.0提供了数PB的网络,以支持跨越“数十万个Trainium芯片”的大型分布式训练作业。

AWS表示,UltraServer级别更高的内存容量、更快的结构和改进的集体引擎的结合旨在减少大型Transformer和MoE模型中的数据移动瓶颈,特别是那些具有较长上下文窗口或多模式组件的模型。在OpenAI开放权重模型GPT-OSS的内部测试中,AWS报告称,与上一代UltraServer相比,每个芯片的吞吐量提高了3倍,推理响应时间加快了4倍,这表明该公司正在利用系统级收益将Trainium3定位为数万亿参数训练和大规模推理。

AWS表示,客户已经在使用Trainium3来降低训练成本,Anthropic、Metagenomi和Neto.ai等公司报告称,与替代品相比,成本降低了50%。AWS还指出,Amazon Bedrock已经在Trainium3上运行生产工作负载,这表明该芯片已准备好进行企业级部署。早期采用者也在推动新的应用程序类:据AWS称,人工智能视频初创公司Decart正在使用Trainium3进行实时生成视频,并以GPU成本的一半实现了4倍的帧生成速度。

AWS已经在开发下一代定制芯片。该公司表示,Trainium4的设计旨在在计算、内存和互连性能方面实现显著提升,包括至少6倍的FP4吞吐量、3倍的FP8性能和4倍的内存带宽。AWS将FP8升级描述为“基础性飞跃”,它可以使组织的模型训练速度至少提高三倍,或服务的推理请求增加三倍,并有望从持续的软件和特定于工作负载的优化中获得额外收益。

为了支持更大的型号和更高的节点级扩展,AWS表示Trainium4还将集成Nvidia的NVLink Fusion互连技术。目标是使Trainium4、Graviton和Elastic Fabric Adapter能够在通用的基于MGX的机架内互操作,从而创建一个灵活的机架规模设计,可以承载GPU服务器和Trainium系统。

随着Trainium3投入生产,Trainium4即将推出,AWS正在为未来做准备,在这个未来,人工智能训练的真正限制不在于加速器,而在于连接它们的网络和系统设计。AWS如何有效地执行这一路线图将决定其在为前沿规模的人工智能构建基础设施的持续竞争中的地位。