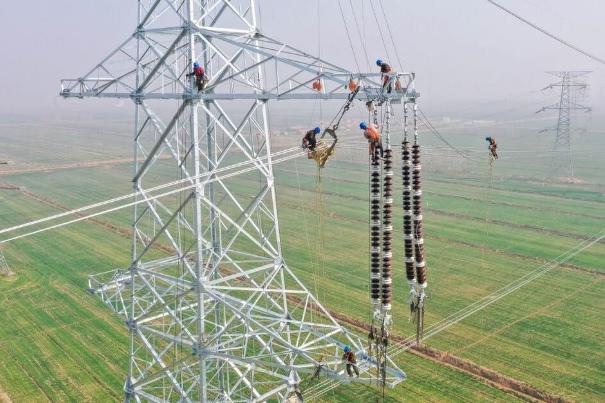

AI的发动机是什么?是算力。而作为算力载体的数据中心,是一个个用电量堪比小城市的巨型铁盒子。随着GPU功耗一代比一代高,马斯克说未来会缺电,这不是贩卖焦虑,这是陈述事实。 算力的飙升正让电力消耗突破想象。英伟达 AI 服务器的功耗增长轨迹清晰可见,从 Ampere 架构到未来的 Kyber 架构,机架级解决方案的功耗预计八年内将飙升 100 倍。 具体产品更能体现这种变化,Hopper 架构服务器机箱功耗约 10 千瓦,最新的 Blackwell 架构已升至近 120 千瓦。 GPU 数量增加与单块 GPU 热设计功耗提升,叠加 NVLink 互连技术的高负载运行,让数据中心能耗以空前速度攀升。 数据中心的 “吃电” 能力已达到城市级别。一个超大规模数据中心消耗 1 吉瓦电力,足以供应约 100 万户美国家庭,这还未计入散热和电力传输的额外损耗。 OpenAI 的 ChatGPT 每天消耗超过 50 万千瓦时电力,应对 2 亿用户请求,这个数字超过 1.7 万个美国家庭的日用电量总和。 国际能源署预测,到 2030 年,仅人工智能一项就可能导致全球电力消耗翻倍,增长速度几乎是电网扩张速度的四倍。 美国的数据中心电力压力已率先显现。 劳伦斯伯克利国家实验室报告显示,2023 年美国数据中心耗电量达 1760 亿千瓦时,占全国总电力的 4.4%,预计 2028 年将增至 3250 亿 - 5800 亿千瓦时,占比提升至 6.7%-12%。 弗吉尼亚州北部的 “Data Center Alley” 作为全球最大数据中心集中地,电力需求到 2030 年可能从 400 万千瓦增至 1500 万千瓦,接近该州电力总负荷的一半。 OpenAI 得克萨斯州数据中心曾因夏季高峰削减 30% 算力,亚马逊 AWS 弗吉尼亚新数据中心因电网容量不足推迟开业。 能源结构的短板让缺口更难填补。 美国数据中心电力 40% 来自天然气,20% 来自煤炭,价格波动与碳排放压力并存。 风电、光伏等可再生能源受天气制约,Meta 爱达荷州数据中心曾因冬季风速不足中断算力,最终被迫接入传统电网。 即便 NuScale 公司推进小型模块化反应堆项目,也因成本与技术问题将投产时间延后至 2029 年,短期内难以形成有效支撑。 中国已提前布局能源底座应对需求。 中核集团 “华龙一号” 福建福清核电 5 号机组连续安全运行超 1000 天,年发电量 100 亿千瓦时,可支撑多个大型 AI 数据中心满负荷运转。 海南昌江 “玲龙一号” 模块化小堆预计 2026 年投运,每年提供 12 亿千瓦时电力,小型化特点适配数据中心定制化供电需求。 产业链协同与技术创新筑牢保障。 西子洁能清洁车间批量生产核电换热设备,洁净度控制达到严苛标准。福清核电站数字孪生系统提升运维效率 30%,中核内蒙古矿业远程开采系统保障核燃料供应。 这些布局让中国在运核电机组稳定运行,为算力增长提供持续电力。 全球电力消耗正以每年 4% 的速度增长,数据中心需求是重要推手。 马斯克的提醒成为行业共识,OpenAI 首席执行官山姆・奥特曼也承认 AI 能耗将超出预期,需要能源突破。中国通过核电领域的战略布局,已为 AI 发展备好 “电力粮仓”,在这场算力与能源的匹配竞赛中,稳稳占据了主动。