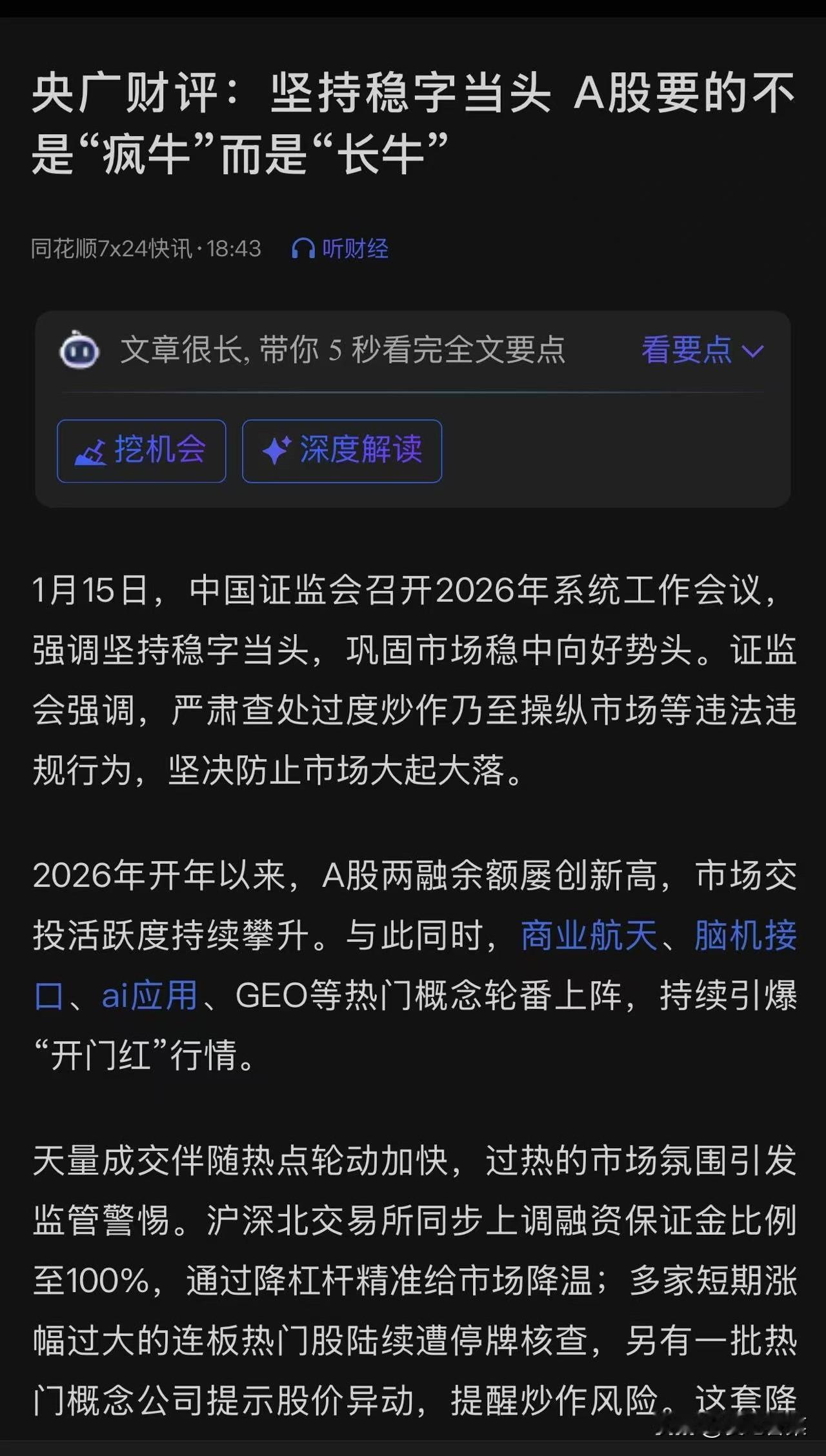

6:45,戒指轻轻震动,不是闹钟响,而是AI根据你的睡眠周期算出的最佳时刻。

你还没睁开眼睛,熟悉的声音就已经在耳边响起来了,「今天有两场会议,下午那场已经被取消。外面14度,比昨天冷。你母亲昨晚发微信,问你周末回不回家」

你嘟囔一句「帮我回复,就说还没确定」,然后翻身又躺了5分钟,全程没碰手机,也没睁眼去看屏幕。

这不是科幻电影,是OpenAI、Meta、谷歌正在下赌注的未来。最快到2026年,你也许真的不用再盯着那块屏幕。

AI根据你的睡眠周期算出的最佳时刻

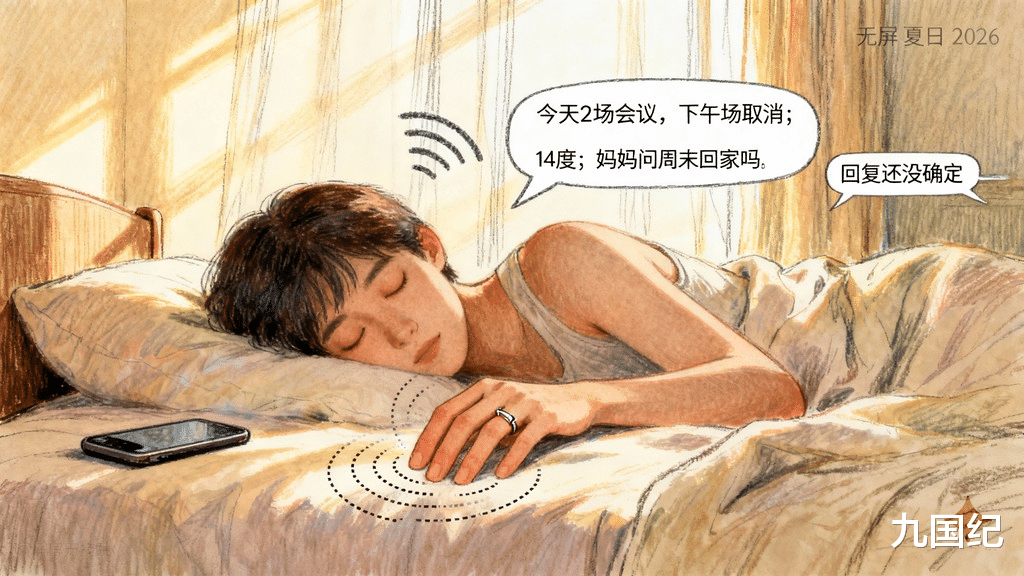

出门戴上眼镜,看起来就是普通的墨镜。走向地铁的时候,它就开始播报邮件摘要只念重点,要是有细节问题询问才会回应。

地铁里刷到一条新闻,要是你想要知道更多,直接就问这件事的背景是什么,AI会用对话的方式给你讲解,就好像旁边坐着个朋友似的。

有人打电话过来,它直接就在耳边响起来,对方听到的就是你正常说话的声音,周围的喧闹都被过滤得干干净净的。

Meta的Ray-Ban智能眼镜已经推出类似功能,它的售价是299到379美元,五麦克风阵列技术让它能在地铁里精准地拾取你的声音,谷歌的音频概述从6月起开始测试把搜索结果转成对话式摘要。

体感差别就在这里体现出来,你不再是看信息,而是听信息眼睛总算是可以留给真实世界。

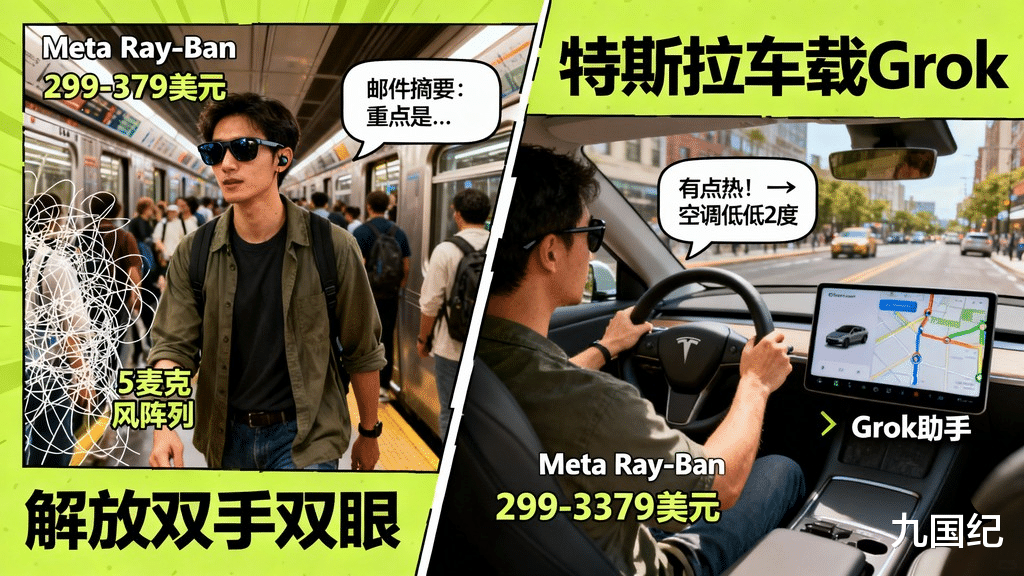

上车后不用设置导航, AI已经根据日历知道你要去哪里。在路上你说有点热,空调就自动调低两度。

AI已经根据日历知道你要去哪里

突然,想起来要给客户发信息,你直接说内容就行,AI会帮你组织语言、确认然后发送,整个过程中,双手都没离开方向盘,眼睛也没离开路面。

特斯拉正在把AI聊天机器人Grok整合到车子里,它的目标是用自然的对话来处理导航、空调、通讯等所有功能,关键的突破在于AI能够明白模糊的指令比如:有点热而不是调到23度这类情况。

车载场景被觉得是音频AI的绝佳战场,缘由很简单,开车的时候人类不能看屏幕,只能用语音。

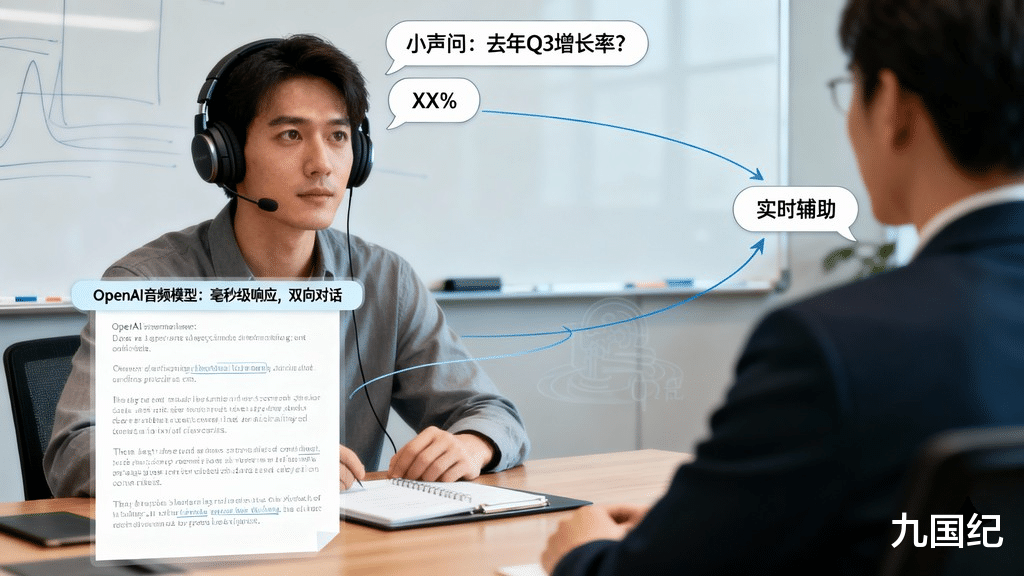

开会的时候,耳机里的AI实时给你整理重点,要是有人提到一个数据你不确定,小声问「去年Q3的增长率是多少」,AI立刻就会回应。

开完会不用去写会议纪要,AI已经生成初稿等你确认,你全程只需要看着人说话,不用低头记笔记,也不用去查资料。

AI已经生成初稿等你确认

OpenAI新推出的音频模型有着一个关键本事,在用户说话的时候能够同时进行播报,这就意味着AI能够成为实时辅助而不是事后响应,延迟降到毫秒级,对话也就真正变成双向流动了。

体感差异又有了升级,AI从用完就关变成一直在旁边就好像一个隐形助手一样。

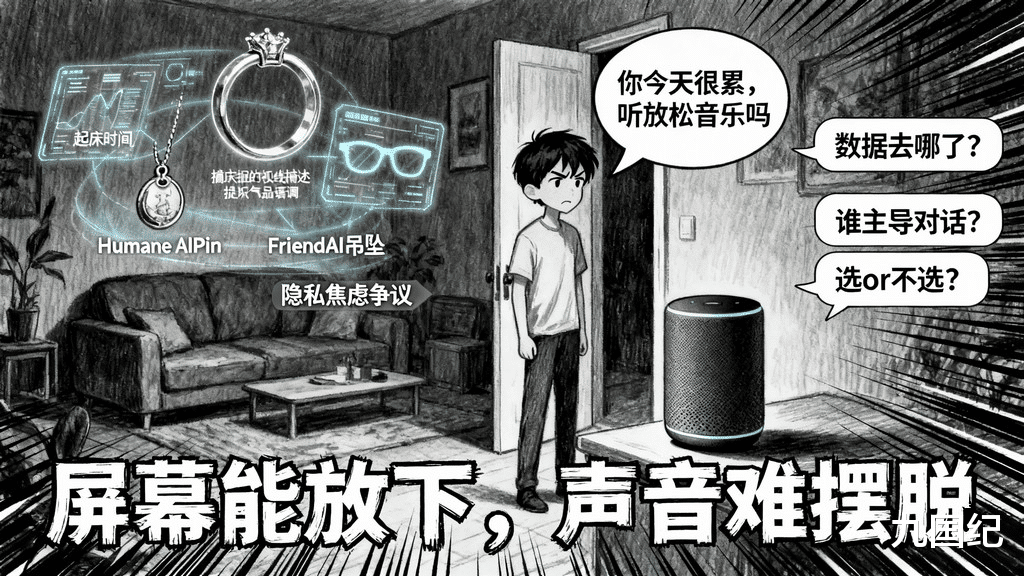

一走进门,家里的音箱就说「你今天好像挺累的,要不要听点放松音乐」。你愣了一下它怎么就知道?

答案是,它听到了你在门口叹的那口气,分析了今天你说话的语调,甚至还记得你上周说最近项目压力大。

这到底是贴心,还是让人觉得害怕。

音频AI懂你的前提就是一直在听你。记录你的生活,FriendAI吊坠这么说,这就引起了隐私和存在焦虑双重争议。HumaneAIPin花了好几亿美元最后以失败收场,其中核心问题之一就是用户对一直被听觉得不舒服。

音频时代,你得说闭嘴才可以让它停下

当AI变成陪伴者的时候,边界到底在哪儿?

时间表比你想象的要近。OpenAI的音频优先设备预计在2026年初推出, Sandbar和Pebble创始人团队的AI戒指也把目标定在同一个时间范围。Meta的Ray-Ban智能眼镜现在就能买到,特斯拉的车载Grok助手正在陆续推送。

技术层面的限制依旧存在

一直不断的监听、处理、回应给电池造成了不少压力,真正自然的对话得要毫秒级的回应,现在还有差别, AI有很大可能自信地说出错误的信息,这个问题还没有彻底解决。

大企业们已经下了很大的赌注,2024年5月OpenAI用65亿美元收购了JonyIve的公司io,目的是设计没屏幕优先的设备,来改正消费电子产品的屏幕依赖情况。

再看看那个2026年的早上,你不用看屏幕,不用敲键盘,AI帮你读消息、回微信、安排日程。

但从另一方面来看,你的戒指清楚你几点醒来,眼镜晓得你看了什么,音箱明白你进门时的心情,这些数据都到哪儿去了,当AI学会在你说话的时候就说话的时候,到底谁掌控对话的主导权。

屏幕时代,你可以选择不看手机。音频时代,你得说闭嘴才可以让它停下。

不用碰手机的无屏生活太香了!但你能接受AI一直监听吗?评论区聊聊你的接受底线~