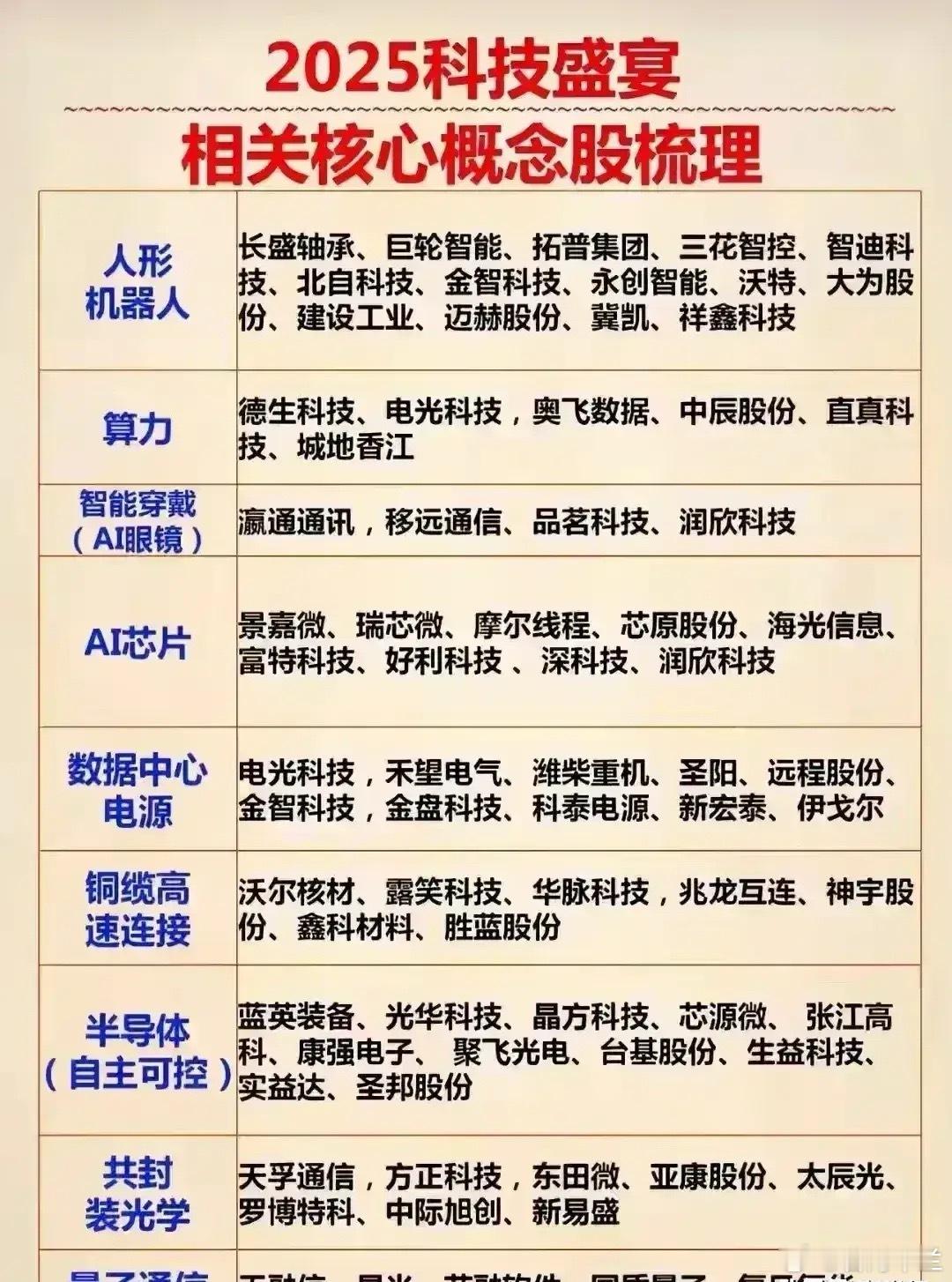

铁云最近的长文有一段话:

也许有读者朋友会提到CUDA的护城河,但大模型应用的特点,决定了其适配工作量要小于之前的CV类应用。

大模型的适配,呈现N+1的特点,市面上主流的大模型就那么几个,底层原理都基本一致,再加上可能存在的一到两个企业定制专家模型,芯片企业可以维持相对较少的软件支持团队。

一家五百人的公司,做这样一款产品,每年大概70-80万出货基本可以做到收支平衡,而办公AIPC的市场显然是大于这个规模的,现在的问题就是,本地化应用生态还有待丰富。

但无论如何,未来大概率会出现入门级独立AI GPU/GPGPU/NPU这一类的产品,成为和高性能游戏本类似的高性能AIPC。

…………………………

这段话的核心观点是:在AI大模型应用场景下,CUDA的护城河相对传统CV(计算机视觉)应用而言确实被削弱了,进入门槛降低了,为新玩家创造了机会。

大模型应用的核心计算模式相对统一且主流模型数量有限,大幅降低了新芯片玩家在软件适配和生态建设上的初始门槛和持续投入成本。

CUDA生态覆盖海量碎片化CV模型的优势在这个特定场景下不那么关键了。